Volltext vs. abgeleitetes Textformat: Systematische Evaluation der Performanz von Topic Modeling bei unterschiedlichen Textformaten mit Python

Universität Trier

Fachbereich II: Sprach-, Literatur- und Medienwissenschaften

Masterarbeit

im Studiengang Digital Humanities

zur Erlangung des akademischen Grades

Master of Science

| Thema: | Volltext vs. abgeleitetes Textformat: Systematische Evaluation |

| der Performanz von Topic Modeling bei unterschiedlichen Text- | |

| formaten mit Python | |

| Autor: | Martin Kocula |

| Betreuer: | Prof. Dr. Christof Schöch |

| Zweitprüfer: | Prof. Dr. Achim Rettinger |

1 Einleitung

Reinold Schmücker

Vervielfältigung und Bereitstellung von Textmaterial ist speziell in Forschungsfeldern der Linguistik, Geistes- und Sozialwissenschaften essenziell. Doch zum Schutze geistigen Eigentums von Autorinnen1 existieren Urheberrechte, die Forschende vor große Hürden stellen.

So behindern in der Computerlinguistik (CL) und den Digital Humanities (DH) Komplikationen mit Urheberrechten nicht nur die Forschungspublikation, sondern auch die Textmaterialbeschaffung moderner Texte an sich ist signifikant erschwert, weil Forschende zusätzliche Bemühungen anstellen müssen, um sie legal von Archiven, Verlagen und Autorinnen erhalten und nutzen zu dürfen. Der Begriff modern ist durchaus relativ, denn das Urheberrecht einer Autorin erlischt erst 70 Jahre nach deren Tod. Da z.B. Thomas Manns frühestes Werk Buddenbrooks im Jahre 1901 veröffentlicht wurde und der Autor im August 1955 verstarb, ist dieses 120 Jahre alte Werk bis 20262 urheberrechtlich geschützt:

Es öffnet sich um 1800, weil für Materialien vor dieser Zeit die technischen Herausforderungen im Bereich Optical Character Recognition (OCR) und Normalisierung von orthographischer Varianz immer noch so groß sind, dass deutlich weniger umfangreiche beziehungsweise qualitativ weniger hochwertige Textsammlungen zur Verfügung stehen als für die Zeit nach 1800. Und es schließt sich um 1920, weil für Texte, die später erschienen sind, in sehr vielen Fällen (...) das Urheberrecht nach wie vor greift und sowohl das Erstellen als auch das Teilen von Textsammlungen mit Dritten damit deutlich erschwert sind.

Dass eine Textsammlung nicht ohne Weiteres geteilt werden kann, erschwert nicht nur für Forschende den Zugang zu den benötigten Daten, sondern auch für potenzielle Anschlussforschende, die nicht vollumfänglich auf die Quelldaten zugreifen können und sich diese ebenfalls mit müßigen Beschaffungsprozessen auseinandersetzen müssen, was den Fokus auf die tatsächliche Forschungsarbeit erheblich stören kann.

Schöch et al. (2020)3 schlagen daher eine pragmatischen Lösung für urheberrechtlich geschützte Textsammlungen vor: abgeleitete Textformate. Denn besonders im Bereich der linguistischen Datenverarbeitung haben sich Methoden des Text-Data-Minings (TDM) etabliert, die Texte in ihrer ursprünglichen (und damit geschützten) Form nicht nur nicht benötigen, sondern Alternativformate sogar bevorzugen.

In Schöch et al. (2020) Abs. 27 werden die typischen TDM-Verfahren aufgeführt:

- Die Klassifikation und Clustering von Texten, u. a. für die Autorschaftsattribution

- Die Extraktion distinktiver Merkmale

- Die semantische Analyse mit Topic Modeling

- Die Analyse von Polarität4 mit Sentimentanalyse

- Der Blick auf Figurenbeziehungen mit der Netzwerkanalyse

- Die Analyse von Beziehungen zwischen Texten, beispielsweise beim Text-Re-Use

- Sowie allgemein der Einsatz von Sprachmodellen für verschiedenste Aufgaben

Ein abgeleitetes Textformat ist eine Entfremdung oder Umgestaltung des Originals, sodass es nicht mehr unter das Urheberrecht fällt. In Schöch et al. (2020) Abs. 43 werden mehrere (nicht zwangsläufige vollständige) Faktoren aufgeführt: die Menge an zusammenhängendem Text liegt unter einer bestimmten Schwelle, der Werkgenuss durch einen Menschen ist ausgeschlossen, die Wiedererkennbarkeit für Lesende gering und die Rekonstruktion des Textes ist nicht trivial oder mit Unsicherheiten behaftet.

Bei den vorgestellten in Schöch et al. (2020) vorgestellten Ableitungen handelt es sich um:

- einfache Term-Dokument-Matrizen

- Segmentweise aufgehobene Sequenzinformationen

- Selektiv reduzierte Information über Tokens

- N-Gramme auf Korpus- und Teilkorpus-Ebene

- einfache Wordembeddings

- kontextualisierte Embeddings

Es wird erwartet, dass jedes Format durch den Sequenzinformationsverlust in Maßen für bestimmte TDM-Verfahren ausreichend effektiv sind, weshalb sich ihre Informationen gegenseitig ergänzen. Sie ermöglichen Archiven die öffentliche Verbreitung ihrer Textdaten, ohne dass Rezipientinnen sich weiter um Lizenzen oder Abkommen kümmern müssen. Denkbar wäre die Erstellung von Formatpaketen, die für einen Text oder eine Textsammlung zur Verfügung gestellt werden und somit alle Informationen zur Verfügung zu stellen, die für ein breites Spektrum an Forschungsthemen nützlich sind.

Diese Masterarbeit beschäftigt sich mit der Frage, inwieweit sich welches Format5 für das TDM-Verfahren Topic Modeling eignet. Hierzu werden diese zunächst generiert und anschließend evaluiert.

In Kapitel 1 wird erklärt, was Topic Modelle sind, wie der LDA-Algorithmus funktioniert, wie sie bewertet und wie Texte für bessere Ergebnisse vorverarbeitet werden können.

Kapitel 2 stellt die abgeleiteten Textformate vor und formuliert Hypothesen hinsichtlich ihrer Eignung für die semantische Analyse.

In Kapitel 3 wird der Workflow zur Erstellung der Formate skizziert. Es werden zudem Strategievorschläge unterbreitet, wie diese in für Topic Modeling sinnvolle Textstrukturen umgewandelt und die Modelle trainiert werden. Umgesetzt wurde dies mit der Skriptsprache Python, da für sie, besonders im Bereich Sprachdatenverarbeitung und Datenanalyse, viele nützliche Bibliotheken existieren. Die einzelnen Schritte werden anhand von Code-Beispielen erklärt und zahlreiche Python-Module und -Bibliotheken für Sprachdatenverarbeitung und Statistik vorgestellt.

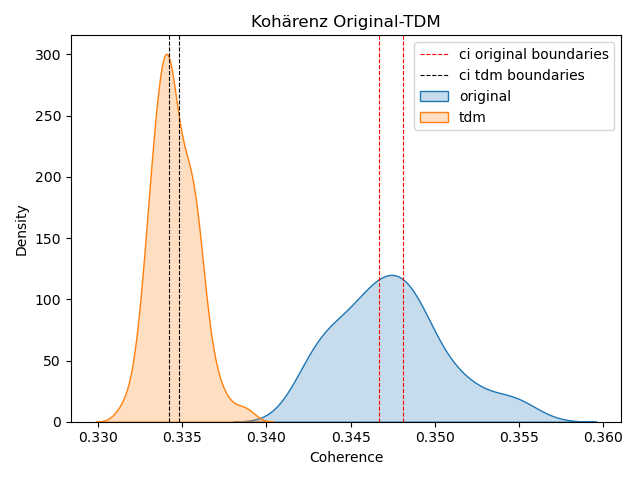

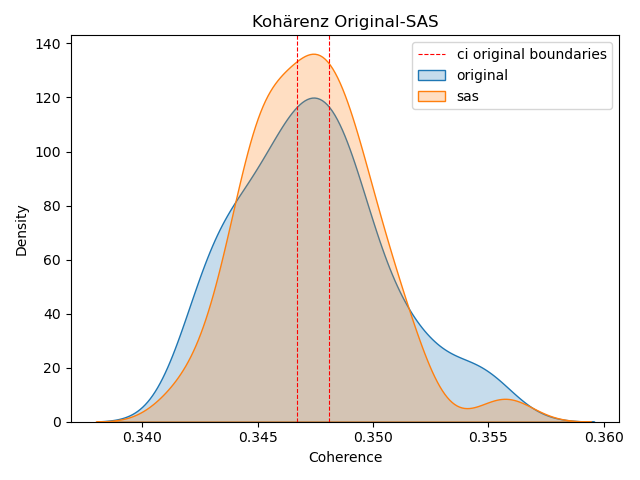

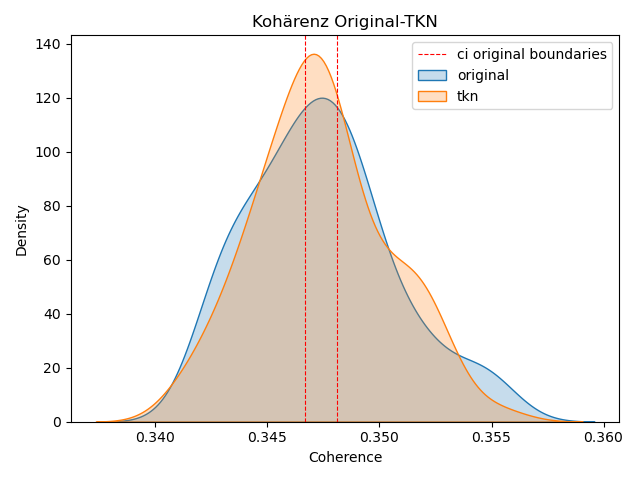

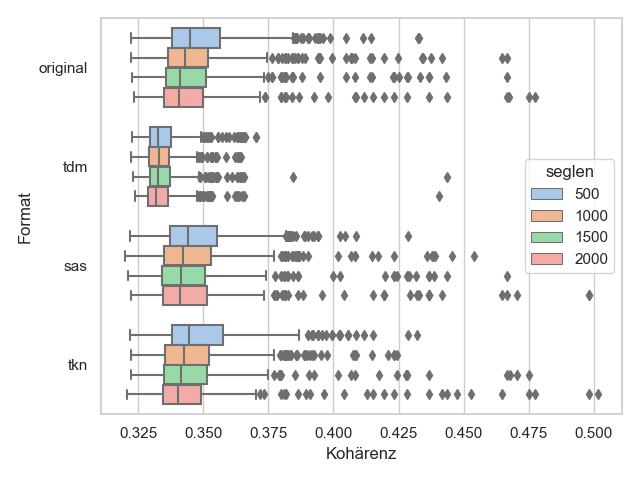

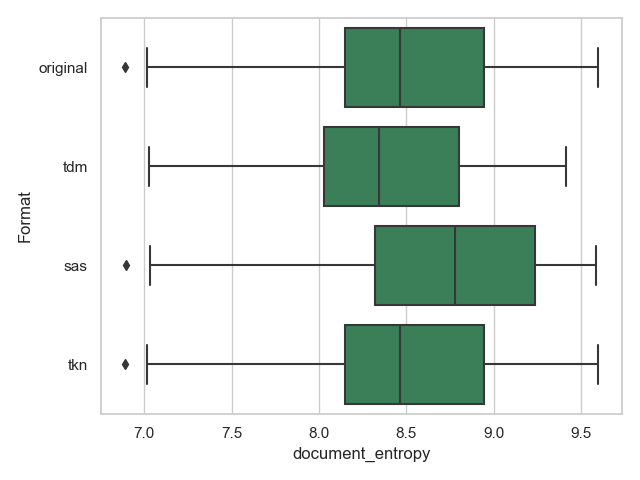

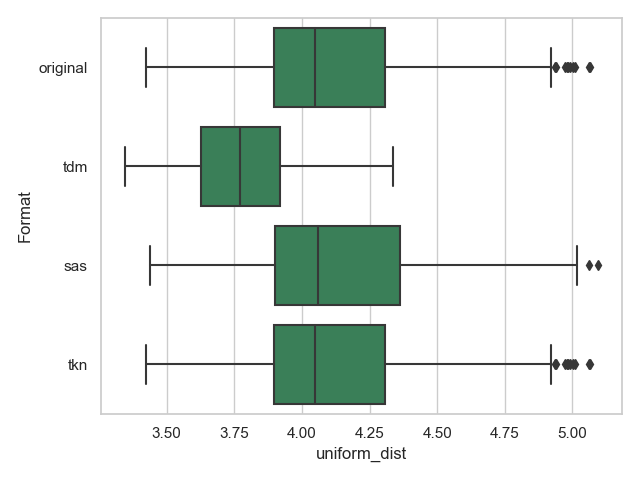

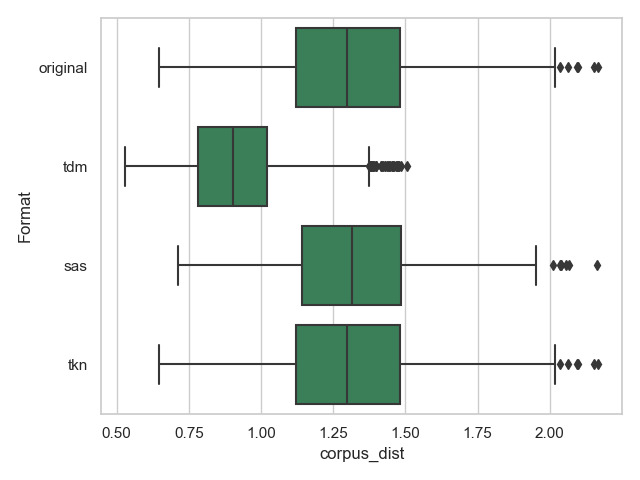

Die Evaluation findet in Kapitel 4 statt, indem primär Kohärenzwerte und Topics paarweise zwischen dem Originaltext und seinen Ableitungen untereinander verglichen werden.

Die Arbeit endet mit einem Fazit, welches die Ergebnisse zusammenfasst und in einem Ausblick beschreibt, welche Fragen offen bleiben und welche Anschlussforschungen sich hieraus ergeben können.

2 Topic Modeling und Evaluationsmethoden

In den folgenden Abschnitten wird erklärt, wie Topic Modeling (TM) funktioniert, welche Tools Modelle erstellen können und wie das Korpus für gute Ergebnisse vorverarbeitet werden muss. Anschließend wird dargestellt, wie die Modelle der Textformate im Vergleich zum Originaltext bewertet werden können. Das grundlegende Verständnis von TM ist Voraussetzung für die Einschätzung der Performanz von Textformaten.

2.1 Latent Dirichlet Allocation

Unter TM versteht man das Erkennen und Extrahieren versteckter (latenter) wiederkehrender Strukturen in sonst unstrukturierten Textkorpora unter Zuhilfenahme von statistischen Verfahren und ist damit eine einschlägige Methode des Text-Data-Minings. TM basiert auf der Annahme, dass jedes Dokument aus einer festen Anzahl von Topics besteht und ein Topic sich aus einer häufigen Kookkurrenz mehrerer Wörter je Dokument ergibt, was von einem Menschen als Thema interpretiert werden kann. Diese Strukturen werden ohne menschliches Zutun bestimmt, was selbst die thematische Erschließung unbekannter, großer Textsammlungen ermöglicht (Block, 2020). Es handelt sich also bei diesem Verfahren um eine Art des unüberwachten maschinellen Lernens.

Das ist besonders nützlich für die Forschung an großen Korpora, deren Lektüre allein durch die schiere Größe und dem damit verbundenen Leseaufwand für einen Menschen schwierig oder nicht aufzubringen wäre. Auf diese Weise kann solch ein Korpus durch TM erschlossen werden.

Man stelle sich ein Beispiel aus dem politischen Alltag vor, wie einen Korpus bestehend aus Bundestagsreden der letzten drei Jahrzehnte. Mit TM können die Themenschwerpunkte dieser Debatten erkannt und, wenn auch die notwendigen Metadaten wie Bundestagsmitglied, Fraktionszugehörigkeit, Jahresangaben vorhanden sind, ausgewertet werden. Stellt man auf dieser Grundlage Grafiken auf, kann u.a. analysiert werden, welche Themen im Allgemeinen diskutiert werden und welche Fraktion mit seinen Mitgliedern eine bestimmte Meinung vertritt.

Aber es gibt geradezu beliebig viele Anwendungsfälle für semantische Untersuchungen: z.B. Feedback aus Fragebögen, Nachrichtenportale, Tweets, Korrespondenzen und nicht zuletzt literarische Texte in Form von Dramen, Erzählungen und Lyrik (wobei hier besonders der Fokus auf metaphorische Sprache erschwerend hinzukommt).

Der von Blei et al., 2003 vorgestellte TM-Algorithmus Latent Dirichlet Allocation (LDA) erfreut sich in den DH (aber auch weit darüber hinaus) so großer Beliebtheit, dass LDA und TM von vielen Forschenden synonym gebraucht werden (Meeks & Weingart, 2012, S. 2f; vgl. Schmidt, 2012, S. 49) und damit standardmäßig verwendet wird6 . Das liegt an der höheren erzielten Genauigkeit der generierten Topics gegenüber der Vorgängerverfahren Latent Semantic Analysis (LSA)7 und Probabilistic Latent Semantic Analysis (PLSA), deren Ursprung in der Information Retrieval liegt8 .

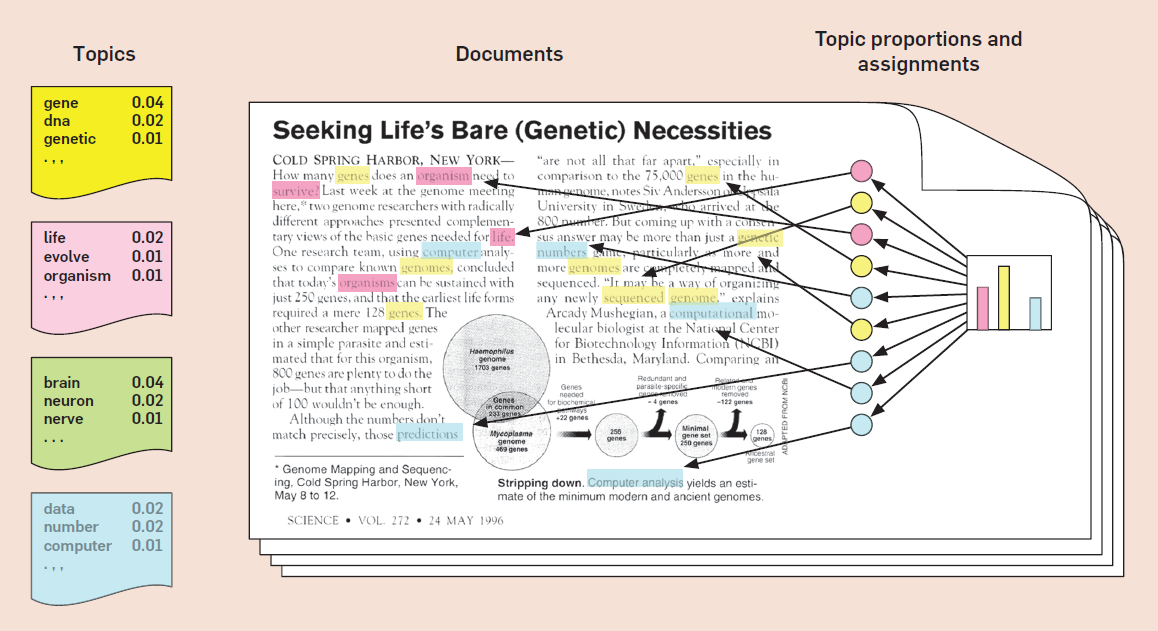

In Abbildung 1 wird veranschaulicht, welche Annahmen LDA trifft. Es wird angenommen, dass jedes Dokument eine zufällige Mischung aus mehreren, unbekannten Topics ist, deren Anzahl ebenfalls nicht bekannt ist. Jedes Topic besteht aus Wörtern, die jeweils eine bestimmte Warscheinlichkeit besitzen, diesem oder auch einem anderen Topic zugehörig zu sein. Auf der linken Seite in der Abbildung 1 sind sie unter Topics beispielhaft als farbige Kästen stilisiert. In diesen Kästen befinden sich Wörter, die diesem Topic zugehörig sind und die Zahl rechts neben jedem Wort stellt ihre Zugehörigkeitswahrscheinlichkeit dar. D.h. jedes Wort ist für ein Topic unterschiedlich relevant. Beispielsweise ist also das Wort gene im gelben Topic wahrscheinlicher als genetic. Es wird eine zufällige Topic-Verteilung für die Dokumente angenommen (Balkendiagramm auf der rechten Seite) und jedes Wort wird zufällig einem Topic zugeordnet (bildlich dargestellt durch den farblichen Hintergrund eines Wortes). Also besteht die Annahme darin, dass Texte aus vordefinierten Topics bestehen und jedes Dokument sich durch ihre unterschiedliche Verteilung auszeichnet.

Ruchirawat, 2020 fasst zusammen, wie der LDA-Algorithmus technisch umgesetzt wird:

- 1.

- User select K , the number of topics present, tuned to fit each dataset.

- 2.

- Go through each document, and randomly assign each word to one of K topics. From this, we have a starting point for calculating document distribution of topics p(topic t|document d) , proportion of words in document d that are assigned to topic t . We can also calculate topic distribution of words p(word w|topic t) , proportion of word w in all documents words that are assigned to topic t . These will be poor approximations due to randomness.

- 3.

- To improve approximations, we iterate through each document. For each document, go through each word and reassign a new topic, where we choose topic t with a probability

p(topic t|document d)∗p(word w |topic t) based on last round’s distribution. This is essentially the probability that topic t generated word w . Recalculate p(topic t|document d) and p(word w|topic t) from these new assignments.- 4.

- Keep iterating until topic/word assignments reach a steady state and no longer change much, (i.e. converge). Use final assignments to estimate topic mixtures of each document ( % word assigned to each topic within that document) and word associated to each topic (% times that word is assigned to each topic overall).

In Schritt 2 wird erklärt, dass die Verteilung bei einer Wiederholung vollkommen zufällig ist und damit keine guten Topics erzielt werden können. Also ist LDA ein iterativer Prozess über Dokumente (Schritte 3 und 4), um stabile Topics zu generieren, die sich ab einer gewissen Anzahl an Iterationen nicht mehr stark verändern und je mehr Dokumente zur Verfügung stehen, desto besser kann das Ergebnis ausfallen.

Die Frage danach, wie viele Topics aus einer Dokumentsammlung ermittelt werden sollen (Schritt 1), ist problematisch, weil sie je nach Korpusgröße und inhaltlicher Kohärenz nicht klar ist. Man kann sich experimentell einer angemessenen Zahl annähern. Eine quantitative Methode besteht darin, mehrere Modelle zu erstellen, dessen Anzahl K bei jeder Iteration inkrementell um eine Schrittgröße bis zu einem im Voraus definierten Maximum erhöht wird. Wie bewertet werden kann, ob ein Modell eine geeignete Anzahl erreicht hat, wird in Kapitel 2.4 ausgeführt.

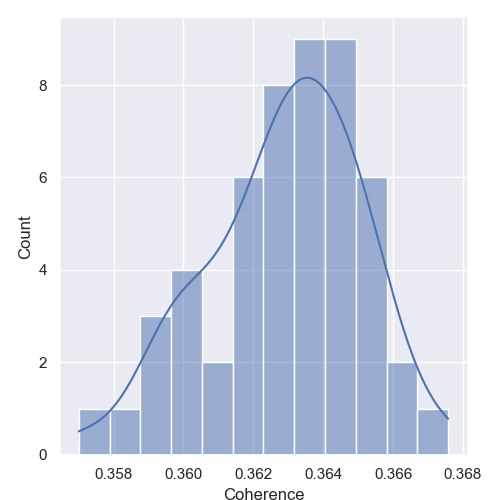

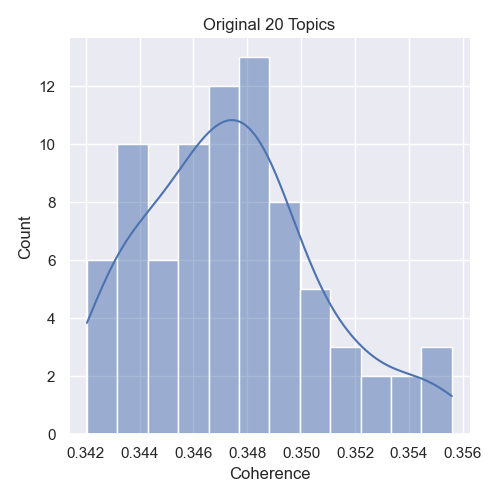

Durch den Zufallscharakter ist es unvermeidbar, dass Modelle, die auf identischer Textbasis berechnet wurden, unterschiedliche Wort- und Topicverteilungen mit sich bringen. Daher wird es notwendig sein, herauszustellen, in welchem Rahmen sich diese Schwankung bewegt, indem mehrere dieser Modelle erstellt und untereinander verglichen werden.

2.2 Bag of Words

Um die Eignung eines Formates einzuschätzen, muss noch darauf eingegangen werden, dass der LDA-Algorithmus auf dem Bag-of-Words-Modell basiert. Das Bag-of-Words-Modell nimmt an, dass die Wortreihenfolge in einem Dokument nicht wichtig für die Ermittlung des Dokumentinhalts ist (vgl. Blei et al., 2003, S. 994). Für jedes Dokument wird ein solches Bag in Form eines Vektors erstellt, der die Tokenhäufigkeit aufzählt Die Annahme ist nur dann gültig, wenn jedes Wort als Unigram angesehen wird, dass also jedes Wort für sich eine Semantik besitzt. Allerdings ergeben oft mehrere aufeinanderfolgende Wörter eine Sinneinheit (N-Gram), wie New York, New York Times oder United States of America, die durch Auflösung ihrer Reihenfolge auch ihre Semantik verlieren bzw. verändern. Trotzdem sind Bag-of-Words-Modelle auch unter dieser vereinfachten Annahme überraschend mächtig (vgl. Mimno, 2020-02-25). Dies wird für die Einschätzung der Textformate interessant. Einerseits ist die Wortsequenz innerhalb eines Dokuments nicht relevant, da sie ohnehin bei der Verarbeitung keine Signifikanz hat. Betrachten wir andererseits das Format einfache Term-Dokument-Matrix auf Basis der Einzeltexte, sehen wir, dass dadurch der Kontext jedes Wortes verlorengeht.

2.3 Vorverarbeitungsschritte

Für möglichst kohärente Topics muss das LDA-Korpus vorbereitet werden. Ziel der Vorverarbeitung ist die Standardisierung der Informationen, Eliminierung von Störfaktoren und irrelevantem Inhalt. Die für diese Arbeit implementierte Pipeline führt die im Folgenden aufgeführten Schritte aus:

Tokenisierung. Darunter versteht man das Aufteilen des Textes in seine Bestandteile, hierzu gehören Wörter und Interpunktionen. Hier sollten vom Tagger sprachspezifische Eigenheiten, mit Bindestrichen verbundene Wörter und Abkürzungen erkannt und voneinander unterschieden werden.

Part-of-Speech-Tagging. Die Auszeichnung jedes Tokens mit seiner Wortart (Nomen, Verb, Adjektiv, u.s.w.) oder Textfunktion (z.B. Satzbegrenzungszeichen). Wenn diese Informationen vorliegen, kann gezielt nach semantisch wertvollen Wörtern gefiltert werden. Funktionswörter, wie Pronomen, Präpositionen, Konjunktionen und Artikel sind hingegen für das Topic Modelling nicht interessant, da sie semantikarme Wörter sind.

Lemmatisierung. Die Rückführung eines Wortes auf seine Grundform, z.B. vom Plural in den Singular (mice wird zu mouse) oder von einem flektierten Verb in sein Lemma (is wird zu be). Anders als beim Stemming, wird bei der Lemmatisierung nicht ausschließlich regelbasiert verfahren9 . Das bedeutet, dass beim Lemmatisieren ein Lexikon genutzt wird, in dem Lemma-Einträge aufgelistet sind, die vom Programm mit dem vorgefundenen Token verglichen wird. Die Verwendung eines lemmatisierten Textes ist sinnvoll, weil damit garantiert wird, dass der LDA-Algorithmus jedes unterschiedliche Token standardisiert vorfindet und damit korrekt aggregieren kann. Zudem können so einige Stoppwörter identifiziert und bereinigt werden.

Segmentierung. Bei Dokumentsammlungen, die große Einzeldokumente enthalten, ist es üblich sie in kleinere Dokumente zu unterteilen, da die generierten Topics bei großen Dokumenten nicht spezifisch genug sind (vgl. Sieg, 2019). Die Zeichenzahl eines Segmentes bewegt sich in der Forschung üblicherweise im drei- bis vierstelligen Bereich (Schöch, 2017; Weitin & Herget, 2017). Es bleibt also auszutesten, welche Segmentgröße sich für das Korpus eignet. Wichtig ist vorrangig, dass die Textformate, soweit möglich an den gleichen Token segmentiert werden, sodass sie den gleichen Inhalt tragen, wie das Original. Deswegen sollte die Segmentierung im Workflow nach der Lemmatisierung stattfinden.

Stoppwörter entfernen. Als Stoppwörter werden die semantikarmen Textbestandteile bezeichnet und werden daher auch entfernt. Über die o.g. Funktionswörter hinaus, werden auch Zahlwörter, und je nach Analyseschwerpunkt Eigennamen hinzugezählt. Man könnte argumentieren, dass es in Texten um z.B. Figuren in der Literatur oder auch reale Personen aus Zeitungstexten (Politiker, Musiker, Sportler) geht. Idealerweise würden diese als eigenes Topic erkannt und entsprechend eingeordnet werden. Schaut man sich allerdings öffentlich zugängliche Stoppwortlisten an, fällt auf, dass dort häufig oder sogar hauptsächlich Eigennamen zu finden sind10 .

Filterung nach Wortarten. Wenn die Vorarbeit geleistet wurde, gestaltet sich die Filterung nach Wortarten relativ einfach. So kann bestimmt werden, welche Wortarten (z.B. nur Nomen) letztendlich im vorbereiteten Korpus enthalten sein sollen. Ist die Bedeutung eines Tags bekannt, kann gezielt nach ihm gesucht werden.

Starke sprachliche Abweichungen von der eigentlich verwendeten Standardsprache stellen für all die o.g. Vorverarbeitungsschritte eine Herausforderung dar. Das gilt für Sachtexte in der Regel nicht, ist aber als sprachliches Stilmittel in fiktionalen Werken bei Figurenrede durchaus vorzufinden. Das hier verwendete Korpus enthält z.B. Rede, die Slang immitiert, darunter Sätze wie diese: ”I sez ’dang the tree!’ Us doan’t take no joy in thrawin’ en, mister.”. Es ist höchst unwahrscheinlich, dass solch ein Fall korrekt mit einschlägigen Sprachverarbeitung-Tools nach den vorgestellten Methoden verarbeitet wird. Allerdings hält sich das Vorkommen im Bezug auf das Gesamtkorpus in solchen Maßen, dass sie in der praktischen Umsetzung vernachlässigt werden können.

2.4 Bewertung der Topics

2.4.1 Menschliche Interpretierbarkeit

Ob ein Topic gut oder schlecht ist, kann ein Mensch subjektiv zumindest anhand seiner Top-Wörter gut einschätzen. Man spricht auch von der Kohärenz eines Topics. Ein Topic sollte dann einen hohen Kohärenzwert haben, wenn sich die Bedeutungen seiner Top-Wörter gegenseitig unterstützen (vgl. Röder et al., 2015, S. 399).

Intuitiv könnte ein Mensch ein kohärentes und damit verständliches Topic unter einer Überschrift zusammenfassen. Beispielsweise dürfte es Lesenden relativ einfach fallen, ein Topic mit den Top-Wörtern game, sport, ball, team mit Labels wie Ballsportart oder Fußballspiel und das Topic sister, father, mother, brother, child mit Familienmitglieder zu versehen. Es handelt sich also um eine interpretationsbasierte Evaluation.

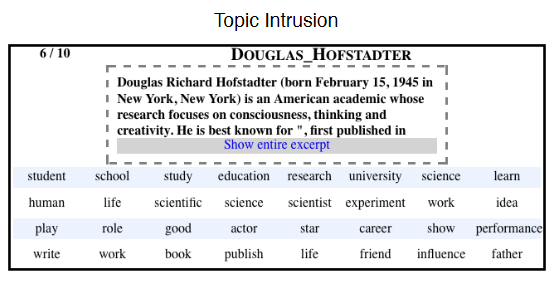

Darauf aufbauend stellen Chang et al., 2009 zwei erweiterte Methoden vor, um zu testen, ob ein Topic gut interpretierbar ist. Zum einen Word Intrusion auf Topic-Ebene, zum anderen Topic Intrusion auf Modellebene. Mit ersterem wird versucht durch Einfügen eines zufälligen Wortes die Interpretierbarkeit eines Topics zu stören. Fügt man also dem Familienmitglieder-Topic ein Wort wie apple hinzu, werden die meisten dieses Wort auch als Störer erkennen können, da es sich semantisch (Frucht) deutlich von den Familienmitgliedern unterscheidet. Das deutet darauf hin, dass das Topic eine hohe Kohärenz hat. Ist andererseits durch das Hinzufügen nicht klar erkenntlich, was das Störwort ist, weist das Topic eine geringe Kohärenz auf. Aus dem Topic {car, teacher, platypus, agile, blue, Zaire} wird beispielsweise nicht klar erkenntlich, welches Wort im Nachhinein hinzugefügt wurde. Es gibt hier keinen klaren gemeinsamen semantischen Nenner zur Kategorisierung. Daher werden Menschen ein zufälliges Wort wählen und dieser Umstand impliziert eine niedrige Kohärenz. Analog wird auf Modellebene verfahren, indem den Testteilnehmenden ein kurzer Auszug aus einem Dokument mit Überschrift präsentiert werden und bewertet werden soll, welches des gegebenen Topics nicht hinzugehört. In Abbildung 2 ist ein Beispiel für Topic Intrusion zu sehen. Anhand des Einleitungstextes ist klar ersichtlich, dass es um einen Wissenschaftler und seine Arbeit geht, daher ist Topic 3 als Störer zu identifizieren.

Da Topics letztendlich für Menschen erstellt werden, wird in dieser Arbeit davon ausgegangen, dass diese Evaluationsmethode die hilfreichste ist. Für die systematische Evaluation allerdings wird hier stattdessen eine quantitative Methode gewählt, mit der die Kohärenz maschinell berechnet werden kann.

2.4.2 Unifying Coherence Framework

In Röder et al. (2015) wird die vierstufige Pipeline Unifying Coherence Framework beschrieben. Mit einem Referenzkorpus kann eine Topic-Kohärenz statistisch errechnet werden. Sie ist geeignet für alle bereits etablierten Kohärenz-Methoden, als auch für die bei Schöch et al. (2020) vorgestellte, vektorbasierte Methode11 . Dabei zeigt sich, dass diese mit menschlichen Bewertungen korrelieren (vgl. Röder, n. d.).

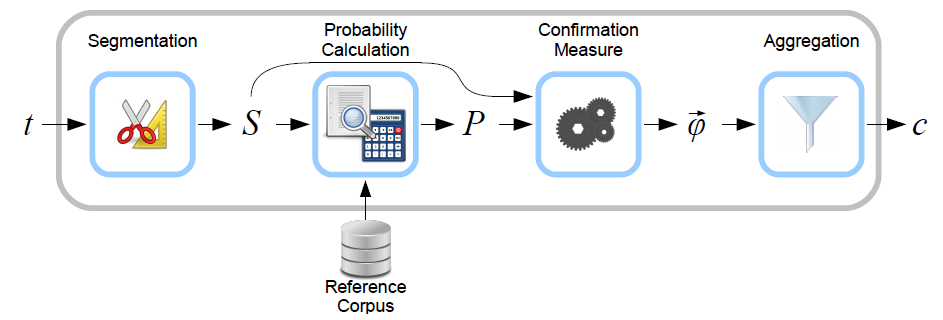

Wie in Abbildung 3 zu sehen, bestehen die Stufen aus Segmentation, Probability Calculation, Confirmation Measure und Aggregation. Wörter aus dem Quelltopic t werden zur Segmentmenge aus Paaren S unterteilt, um sie untereinander zu vergleichen. Dabei gibt es viele Arten zu segmentieren, z.B. Einzelwortpaare, Paare aus Wortpaaren und weitere (vgl. Röder et al., 2015, S. 3f). Das ist von der Entscheidung der Nutzenden bzw. der Implementation des Tools abhängig. Die Wahrscheinlichkeiten P werden abhängig vom gewählten Referenzkorpus berechnet, der idealerweise nicht bloß ein Teil des untersuchten Korpus ist, sondern ein dem Model unbekannter Text. Aus Segmentmenge S und Wahrscheinlichkeiten P werden Bestätigungsmaße (Confirmation Measure) φ berechnet, die letztendlich zum Kohärenzwert c aggregiert werden. Dieser Wert kann mit unterschiedlichen Methoden berechnet werden. Im Grunde handelt es sich entweder um eine Wahrscheinlichkeitsrechnung oder einen vektorbasierten Ansatz, der nach Röder, Both und Hinneburg (2015) die besten Ergebnisse liefert. Wichtig ist für diese Untersuchung, dass nur die Kohärenzmaße verglichen werden, die auf gleiche Art mit den gleichen Parametern ausgerechnet wurden, da die Zahlen sonst nicht miteinander vergleichbar sind.

Das Tool Palmetto funktioniert auf Basis dieses Frameworks und ist als Web-Service verfügbar, für den auch der einfach zu bedienende Client palmetto-py12 existiert, um Palmetto in den eigenen Python-Code einzubinden. Die Nutzung des Online-Services kann problematisch sein, wie eigene Erfahrungen zeigen: Zu Beginn der Verfassung dieser Arbeit war der Service nicht erreichbar, doch der Fehler konnte in Zusammenarbeit mit Röder behoben werden und der Service funktioniert zum aktuellen Zeitpunkt wieder. Wenn also Lesende dieser Arbeit auf Komplikationen stoßen, lohnt sich ein Blick ins Repository13 . Daher steht Palmetto alternativ auch lokal als Java-Tool zur Verfügung: Dafür kann der Source-Code heruntergeladen und als Bibliothek für eigene Anwendungen verwendet oder als Java-Jar aus der Kommandozeile heraus gesteuert werden14 . Der Nachteil besteht hier dabei allerdings darin, dass lokal das über 6 GB große Wikipedia-Referenzkorpus auch heruntergeladen werden muss.

Eine Alternative stellt die Open-Source-Bibliothek Gensim (von Generate Similar) dar. Gensim ist ein mächtiges Werkzeug für Textverarbeitung und Erstellung von Topic Models und Word-Embeddings, welche von Radim Řehůřek und seinem Team entwickelt und gepflegt wird (s. Řehůřek & Sojka, 2010). Sie ist in Python geschrieben und erscheint daher gut geeignet für die Integration in diese Untersuchung. Neben den o.g. Funktionen können mit Gensim auch Kohärenzen berechnet werden, indem Objekte namens CoherenceModel() erstellt werden. Dafür wurden die Stufen des Unifying Coherence Frameworks implementiert und können mit den ebenfalls in Gensim erstellten Topic Modellen ausgerechnet werden. Allerdings wird für Gensims Kohärenzberechnung kein externes Referenzkorpus für die Wahrscheinlichkeitsberechnung verwendet (Schritt 2 im Framework). Es handelt sich also um ein intrinsisches Verfahren, dessen Ergebnisse kritisch zu hinterfragen sind, da die Kohärenz auf dem Quelltext berechnet werden. Sinnvoller erscheint die Betrachtung, soweit möglich, mit einem gleichsprachigen externen Korpus. So kann geprüft werden, ob die Kohärenzen nicht nur innerhalb des abgekapselten Quellkorpus sinnvoll sind.

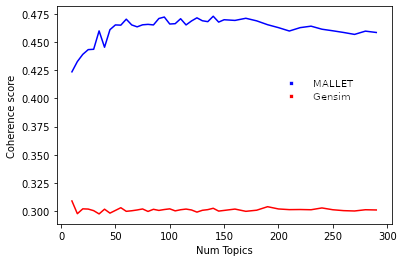

In dieser Masterarbeit prüft der Autor zwei LDA-Implementationen auf ihre Performanz: zum einen Gensims LDA-Modelle und zum anderen die, die von MALLET (MAchine Learning for LanguagE Toolkit) erstellt werden können.(McCallum, 04/05/2021). Es handelt sich um ein in Java geschriebenes und dadurch plattformunabhängiges Programm, das einen Korpus einliest, ein LDA-Modell darauf trainiert und schließlich Topics generiert. MALLET wurde bereits vor ca. 19 Jahren (2002) publiziert und mutet in der Bedienung für heutige Verhältnisse veraltet bzw. umständlich an. Das liegt in erster Linie daran, dass das Interface lediglich die System-Kommandozeile darstellt und über die Befehle einzeln auszuführen sind. Allerdings können Nutzende den quelloffenen Code in ihre eigenen Java-Applikationen einbinden und dessen API verwenden. Alternativ kann MALLET auch über Gensims Implementation genutzt werden, was aber Einschränkungen in der Parametersetzung mit sich bringt. Zudem sind die Analysedaten von MALLET selbst damit nicht zugänglich, die als separate Dateien auf dem System gespeichert werden. Besonders für kleinere Korpora, wie sie in den Geisteswissenschaften im Vergleich zu den enormen Mengen an Internetdokumenten (z.B. Tweets oder Nachrichtenportale) üblich sind, soll erfahrungsgemäß MALLET bessere Ergebnisse liefern als die LDA-Implementierung in Gensim.

2.4.3 MALLETs Diagnostik-XML

Über die extrinsische Methode, also durch den Vergleich zwischen einem fremden Korpus und dem eigenen, hinaus, kann noch die intrinsische Variante zur Evaluation herangezogen werden, indem sie für jedes Format für sich erstellt und betrachtet werden kann.

MALLET kann eigene Analysen durchführen und speichert diese in mehreren Dateien. Um zu bewerten, inwiefern Topics je nach Textformat besser oder schlechter sind, kann eine von MALLET generierte Diagnose-XML herangezogen werden. Sie enthält für jedes erstellte Modell Informationen über Token und Wörter in Bezug auf die Dokumente. Solch eine Datei hat den folgenden Aufbau:

<model>

<topic id="16" tokens="4960.0000" document_entropy="6.3355" word-length="5.2500" co-herence="-598.4534"

uniform_dist="4.8426" corpus_dist="3.8750" eff_num_words="72.1311" token-doc-diff="0.0104"

rank_1_docs="0.1478" allocation_ratio="0.0140" allocation_count="0.0770" exclusivity="0.4766">

<word rank="1" count="377" prob="0.07601" cumulative="0.07601" docs="184"

word-length="5.0000" coherence="0.0000" uniform_dist="0.5701" corpus_dist="0.4515" token-doc-diff="0.0025"

exclusivity="0.9669">wheat</word>

</topic>

</model>

Wie zu sehen ist, werden für Topics (<topic>) und ihre Top-Wörter (<word>) je eigene XML-Elemente generiert (Z. 2 u. 3, topic und word) und mit zahlreichen Attributen ergänzt. Die Beschreibungen sind auf der offizielle Homepage zu finden (McCallum, 2002), von denen eine Auswahl hiermit zusammengefasst ist:

- tokens misst die Anzahl der Wort-Token, die diesem Topic zugewiesen sind.

- document_entropy beschreibt die Entropie eines Dokuments bzw. seine Vorhersagbarkeit. Ein Topic mit hoher Entropie verteilt sich gleichmäßig über alle Dokumente, eins mit niedriger in wenigen.

- word-length ist der Durchschnitt der Wortlänge, gemessen in seinen Characters, der Aufschluss darüber gibt, wie spezifisch ein Topic ist. Es wird angenommen, dass längere Wörter spezifischer sind als kürzere.

- coherence ist MALLETs Kohärenzwert, der nicht nach dem Unifying Framework generiert wurde.

- uniform_dist misst, wie spezifisch ein Topic ist. Je höher der Wert, desto spezifischer. Berechnet wird die Distanz mit der Kullback-Leibler-Divergenz15 .

- effective number of words misst ebenfalls die Spezifizität.

- corpus_dist misst die Distinktivität eines Topics. Der Wert korreliert mit der Wortzahl des Korpus. Ebenso mit Kullback-Leibler-Divergenz berechnet.

- rank 1 documents misst die Frequenz, mit welcher das Topic meistfrequentiert in einem Dokument ist. Je höher der Wert ist, desto korpusspezifischer.

Interessant sind hauptsächlich die Attribute document_entropy, uniform_dist und corpus_dist für diese Untersuchung und sollten zusammen mit den Kohärenzen ein umfassendes Bild über die Modellunterschiede bieten.

3 Die Formate

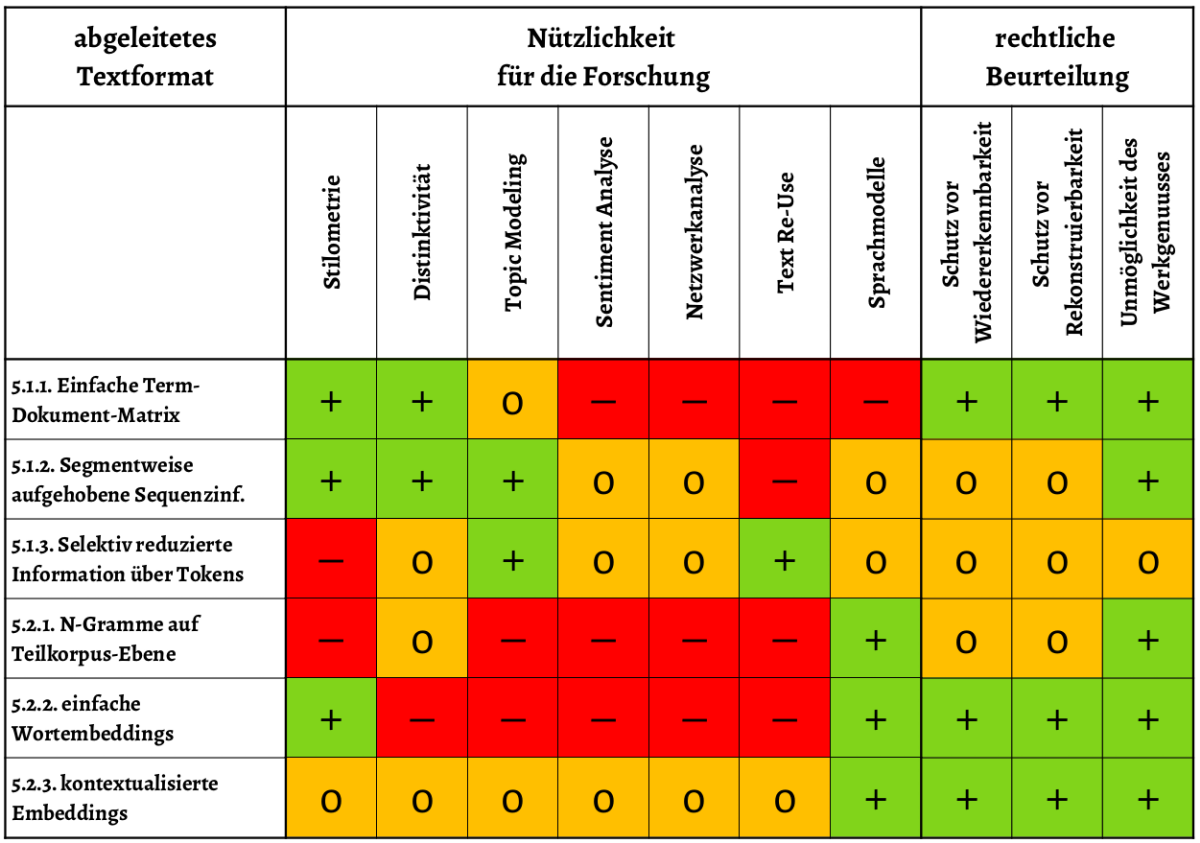

Abbildung 4 stellt eine Übersicht über die erwartbare Nützlichkeit von Textformaten für verschiedene DH-Methoden dar.

Es ist zu sehen, dass die Erwartungen an die Term-Dokument-Matrix nicht hoch sind. Gut zu eignen scheinen sich aber die beiden Formate segmentweise Aufhebung der Sequenzinformation und die selektiv reduzierte Information über Tokens. Schlecht oder nicht geeignet hingegen sind die N-Gramme.

Im Folgenden wird beschrieben, welche Eigenschaften die Formate aufweisen und Erwartungen über ihre Eignung formuliert, die sich darin bemisst, welche Kohärenzen sie im Vergleich zum Original erreichen können.

3.1 Term-Dokument-Matrix

Die Term-Dokument-Matrix stellt wegen der eingeschränkt vorhandenen Sequenzinformation sicher ein für TM problematisches Format dar und wird weniger kohärente Topics erzeugen als das Original.

|

|

|

| Token | Häufigkeit |

|

|

|

| His_PP$_his | 125 |

|

|

|

| England_NP_England | 125 |

|

|

|

| other_JJ_other | 123 |

|

|

|

| Lucretia_NP_Lucretia | 123 |

|

|

|

| us_PP_us 122 | 122 |

|

|

|

| character_NN_character | 120 |

|

|

|

Sie enthält die Häufigkeitsinformationen über jedes im Quelltext vorkommende Token und kann wie in Tabelle 1 dargestellt aussehen. Die auf Basis von Einzeltexten erstellten Formate sind dem über Dokumentgrenzen hinweg erstellten vorzuziehen, denn dort ist der semantische Inhalt noch in grober Weise gegliedert und die Sequenzinformation nicht vollkommen verloren. Auf Basis des Gesamtkorpus ist diese Information nicht mehr enthalten und sie könnte nur mit verschwindend geringer Wahrscheinlichkeit zufällig wiederhergestellt werden, also kann das als ausgeschlossen angesehen werden. Erwartbar sind daher bei der ersten Variante kohärentere Topics als bei letzterer, allerdings dürften die Ergebnisse trotzdem nicht zufriedenstellend sein, da es sich um Romane mit zehntausenden Wörtern handelt. Je kleiner also die Einzelwerke oder -dokumente eines Korpus sind, desto größer die Chance auf bessere Topic Models.

Um einen Text aus einer Matrix zu erstellen muss jeder Term mit seiner Anzahl multipliziert werden, sodass sie tatsächlich als String vorhanden sind. Es wäre sinnlos, solche Strings mit LDA zu verarbeiten, da so über weite Passagen hinweg immer gleiche Token aufeinanderfolgen und somit Dokumente entstehen würden, die u.U. nur aus aufeinanderfolgenden Kommata oder Funktionswörtern (z.B. Konjunktionen) bestehen. Stattdessen kann eine textähnliche Struktur erreicht werden, indem sie zufällig neu angeordnet werden. Dieser Prozess ist technisch relativ einfach umzusetzen, wird aber mit großen Korpora durch die Multiplikation vermutlich längere Rechenzeiten verursachen. Trotzdem sind die durch Zufallsanordnung erstellten Dokumente entweder semantisch unsinnig oder es werden andere Topics aufgedeckt, als sie tatsächlich im Quelltext enthalten waren.

Ein Schlüssel zur Verbesserung dieses Formates liegt in der Segmentgröße. Denkbar ist die einfache TDM in kleinere Segmente zu unterteilen, indem die Quelldokumente vorsegmentiert werden. Praktisch kann das umgesetzt werden, indem man vor der Erstellung der TDM das Gesamtdokument halbiert und aus der ersten und zweiten Hälfte der Wörter die Matrizen erstellt, z.B. aus einem Text mit 40000 Token zwei kleinere Segmente mit 20000. So bleibt zumindest äußerst grob die Information erhalten, ob die Wörter jeweils eher am Anfang oder am Ende stehen und ist bei großen, epischen Texten unproblematischer als beispielsweise bei Zeitungstexten. Es kann dann rekursiv verfeinert werden, indem jeweils jede Hälfte weiter halbiert, gedrittelt oder geviertelt wird, um die Position der Wörter in Segmenten immer weiter einzukreisen. Alternativ kann vom Nutzer auch eine relativ große Segmentgröße manuell bestimmt werden, doch sollte diese deutlich größer sein, als die für das Topic Modeling übliche Größe von 500-2000 Token. Diese Zahlen sind nur grobe Richtwerte und sind daher nicht als absolute Grenzwerte einzuordnen. Das Format lässt sich daher nur eingeschränkt für Topic Modeling verwenden und bietet allenfalls einen äußerst groben Überblick über den Inhalt des Textes durch inkohärente Topics. Die Strategie der immer feineren Segmentierung sei allerdings nicht in der Praxis empfohlen. Der Vorteil einer TDM liegt in ihrer Kompaktheit, der auf diese Weise stark untergraben wird. Zudem steigt der Rechenaufwand durch die Aggregierung und anschließenden Auflösung der Matrix ins Textformat erheblich an.

Daher bietet sich das im folgenden Unterkapitel vorgestellte Textformat, der segmentweisen Aufhebung der Sequenzinformation (SAS), als bessere Alternative an, da sie den gleichen Informationsgehalt aufweist, wie mehrere segmentierte Term-Dokument-Matrizen.

3.2 Segmentweise Aufhebung der Sequenzinformation

Führt man den Gedanken fort, dass kleiner werdende Dokumente bessere Ergebnisse erzielen und unterteilt somit Einzeltexte in noch feinere Segmente, dann bilden die so erstellten Matrizen gewissermaßen die Basis für dieses Format. Technisch gesehen ist das keine empfehlenswerte Herangehensweise, weil so die Rechenzeit durch die Multiplikation steigt. Stattdessen sollten die Einzeltexte zunächst segmentiert und deren Token zufällig vertauscht werden, denn dieser Prozess ist weniger aufwendig und sollte daher der TDM vorgezogen werden.

Sherlock_NP_Sherlock chemical_NN_chemical the_DT_the doing_VVG_do

for_IN_for the_DT_the there_EX_there if_IN_if rooms_NNS_room

the_DT_the he_PP_he second_JJ_second me_PP_me ._SENT_. Jove_NP_Jove

at_IN_at hansom_NN_hansom gave_VVD_give lodgings_NNS_lodgings

comfortable_JJ_comfortable my_PP$_my you_PP_you to_TO_to am_VBP_be

._SENT_.

Wird dieses Format auf der gleichen Segmentbasis erzeugt wie das Original, sollte das Format die gleichen Kohärenzen erzielen können, denn jedes Segment beinhaltet die exakt gleichen Token. Wie oben erläutert, erstellt ein LDA-Algorithmus Bag-of-Word-Modelle auf Basis jedes Dokuments, wodurch ein aus dem Original generiertes Bag-of-Words-Modell keinen Unterschied zu diesem Format aufweisen dürfte.

Diese Eigenschaft bietet zudem den praktischen, einzigartigen Vorteil gegenüber anderen Formaten, dass er für das Topic Modeling auf exakt gleiche Art vorverarbeitet wird, ohne dass eine zusätzliche Programmlogik entwickelt werden muss. Der Zwischenschritt zur Erlangung einer Textform wie bei den anderen Formaten entfällt komplett.

3.3 Selektiv reduzierte Information über einzelne Tokens

Das Format der selektiv reduzierten Information über einzelne Tokens (TKN) ist ebenso vielversprechend und sollte ebenfalls keine signifikant schlechteren Kohärenzen erzielen als das Original.

Es gehen für Topic Modeling praktisch keinerlei Informationen verloren, da für semantische Analysen ohnehin nur bestimmte Wortarten von Interesse sind und enthält im Grunde, sofern auch hier ein Segment aus den gleichen Token besteht, für TM die gleichen relevanten Informationen. Zu den semantisch interessanten Wortformen zählen sicher Substantive, aber eventuell auch Verben und Adjektive und Adverbien. Andere Wörter und Zeichen werden ohnehin herausgefiltert und entfernt.

IN DT year_NN_year CD PP took_VVD_take PP$ degree_NN_degree IN NP IN NP

IN DT NP IN NP , CC proceeded_VVD_proceed TO NP TO go_VV_go IN DT

course_NN_course prescribed_VVN_prescribe IN surgeons_NNS_surgeon

IN DT army_NN_army SENT VHG completed_VVN_completeWird also ein Format erstellt, bei dem eben nur jene Wortarten erkenntlich sind und die restlichen verschleiert, dann greift dieser Filter ebenfalls und es stehen die relevanten Informationen an denselben Stellen wie im Original. In Code 3 ist schon zu sehen, dass hier lediglich noch die Token entfernt werden müssen, die nicht Teil eines Features (in der Form Token_Wortform_Lemma) sind. Dieses Muster in einem Skript zu erkennen stellt keine große Herausforderung dar, da in diesem Beispiel einfach jedes mit Leerzeichen getrennte Wort auf die Länge seiner Bestandteile geprüft werden kann. Ist die Länge gleich 3, wird das Wort behalten, andernfalls wird es entfernt.

Ein Nachteil dieses Formates ist die Unwiederbringbarkeit der herausgefilterten Wortarten. Sind diese erst entfernt worden, kann diese Information nicht wiederhergestellt werden, was bei der SAS anders ist. Dort können die Informationen jederzeit anders gefiltert werden, bei der TKN müsste dafür immer eine neue Datei zur Verfügung stehen, wenn doch andere Informationen benötigt würden.

3.4 N-Gramme

N-Gramme sind sehr problematisch, denn Sequenzinformationen sind zum größten Teil verloren. Lediglich die N-Gramme selbst sind sehr kurze Textsequenzen, die aber kaum verwertbar sein dürften. Es handelt sich nämlich um eine tabellarische Häufigkeitsdarstellung von kurzen Wort- bzw. Tokensequenzen, dessen Länge üblicherweise 2-5 beträgt. Soll beispielsweise für den String ’This is a text with 7 Tokens’ 3-Gramme erstellt werden, wird dies für jedes einzelne erstellt. Die 3-Gramme für diesen String lauten also: ’This is a’, ’is a text’, ’a text with’, ’text with 7’ und ’with 7 Tokens’, sowie aus den Resten ’7 Tokens’ und ’Tokens’. Beim Anblick dieser 3-Gramme wird allerdings klar, dass der Text sich vollständig aus diesem Format rekonstruieren ließe (man füge nur die ersten Token jedes N-Gramms aneinander) und ist daher aus urheberrechtlicher Sicht äußerst bedenklich. Eine naive Entfremdungsmaßnahme könnte darin bestehen, die Reihenfolge der N-Gramme vollkommen zufällig neu anzuordnen, was bei großen Korpora die Rekonstruktion des Textes erschweren würde.

Es können also nicht alle N-Gramme aufgelistet werden, daher muss Information entfernt werden, indem eine Mindesthäufigkeit (Threshold) definiert wird. Das bedeutet, die N-Gramm-Häufigkeit muss in einem Dokument höher sein, als die definierte Mindesthäufigkeit (>1). Damit also beispielsweise das 3-Gramm ’is a text’ bei Mindesthäufigkeit 4 im Format aufgenommen wird, müsste es in einem Dokument mindestens vier mal gezählt werden. Dies ist bereits bei kleineren N-Grammen unwahrscheinlich, aber möglich. Damit wäre die Rekonstruktion nicht mehr möglich, da ein erheblicher Tokenanteil entfernt wurde. Es bleibt aber fraglich, ob mit dem Bruchteil der ursprünglichen Token überhaupt noch sinnvolle Topics erstellt werden können und die Wahrscheinlichkeit, dass beispielsweise ein 5-Gramm in einem relativ kleinen Segment häufiger als ein mal vorkommt, ist verschwindend gering. Das sollte zur Folge haben, dass diese nur dann ermittelt werden können, je größer die Segmentgröße gewählt wird.

Entfernt man sich aber von der Dokumentebene und aggregiert die N-Gramme über (alle) Dokumentgrenzen hinweg, kommt wie bei den Korpus-TDM erschwerend hinzu, dass keinerlei Information darüber bekannt ist, wo sich N-Gramm-Kookurrenzen finden. Die bestmöglichen (das ist in diesem Fall vermutlich noch deutlich schlechter als bei jedem anderen Format) Ergebnisse sollten demnach mit einer Balance aus N-Gramm-Größe, Mindesthäufigkeit und Segmentlänge erzielt werden können. Für nützliches Topic Modeling dürfte dieses Format allerdings nicht geeignet sein und ein Vergleich mit dem Bruchteil der Textmenge mit dem Original kaum sinnvoll.

Tabelle 2 zeigt eine N-Gramm-Matrix aus N-Gramm-Größe 3, welche über alle verfügbaren Dokumente des Korpus aggregiert wurden.

|

|

|

| 3-Gramm | Häufigkeit |

|

|

|

| say mind do | 10 |

|

|

|

| want say anything | 10 |

|

|

|

| day come say | 10 |

|

|

|

| shake head seem | 10 |

|

|

|

Zudem ist es schwierig, einen klaren Vorschlag zur Rekonstruktion eines textnahen Formates zu definieren. Denkbar ist ein ähnliches Vorgehen wie bei der TDM, nur das hier jedes N-Gramm als Einheit vervielfältigt wird und dann auch als Einheit wieder zufällig im String angeordnet wird. Durch Beibehaltung der N-Gramm-Einheiten ist zumindest die tatsächliche Kookurrenz dieser Wörter garantiert.

4 Der Workflow

Um die Praktikabilität von Textableitungen für TM zu untersuchen, müssen sie zunächst aus einem Originalkorpus durch Informationsreduktion tatsächlich erstellt und anschließend systematisch aufbereitet werden, sodass eine für TM geeignete Textdatei entsteht. Das bedeutet, dass für jedes Format Algorithmen entwickelt wurden, die die eventuell hinzugefügten Metainformationen (Sequenzinformationen, Part-of-Speech-Tagging, Häufigkeitsangaben) verwerten, filtern und anschließend entfernen. Auf diese Weise werden die Formate in quasi-natürliche Sprache umstrukturiert. Diese Pseudotexte werden anschließend wie Originale für TM vorverarbeitet, mit denen einschlägige TM-Tools schließlich in der Lage sind Topics zu erzeugen. Es werden bewusst Formate erstellt, die, sofern sinnvoll und möglich, nicht bereits an sich für das TM optimiert sind, sondern in einer allgemeinen Form für alle Text-Data-Mining zur Verfügung gestellt werden können. Das heißt, dass alle Formate alle Informationen zu Token, Wortart und Lemma zur Verfügung stellen und nicht etwa schon für TM vorgefiltert sind. Damit wird ein Vorschlag unterbreitet, wie Forschende mit den Formaten umgehen könnten.

Um das zu Erreichen, wird der Prozess als Workflow abgebildet. Dieser Workflow wurde als Aneinanderreihung mehrerer separater Prozesse realisiert, was entscheidende Vorteile mit sich bringt. Durch die schrittweise Verarbeitung der Textdaten können Skripte16 je einer Stufe dediziert werden, was dem Anwender eine höhere Übersichtlichkeit und Nachvollziehbarkeit über den Gesamtprozess ermöglicht. Die Zwischenschritte werden auf diese Weise im Dateisystem nach und nach persistiert und gehen bei einem unerwartetem Abbrechen des Skriptes nicht verloren. Denn mit dem Anstieg der Datenmengen kommt es bei komplexeren Verarbeitungsschritten dazu, dass sich die benötigte Rechenzeit erhöht. Der Verlust jeglichen Fortschritts ist ein Ärgernis, womit aber mit diesem Vorgehen etwas entgegengesetzt werden kann. Zudem gestaltet sich das Debugging (Ausfindigmachen und Ausmerzen von Programmfehlern) und die Modifikation des Codes als signifikant einfacher, weil so die Logik in kleinere, in sich geschlossene Skripte unterteilt ist. Diese in sich geschlossenen Skripte können auch außerhalb dieser Pipeline für andere Untersuchungen weiterverwendet werden. Zur Verwaltung solcher Teilskripte bietet es sich an, übergeordnete Kontrollskripte zu erstellen. Diese können je Format und Stufe die Quell- und Zielordner bestimmen und ermöglichen es dem Anwender spezifische Verarbeitungsparameter zu definieren.

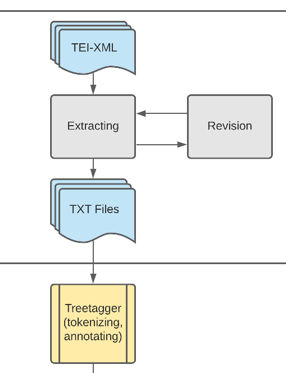

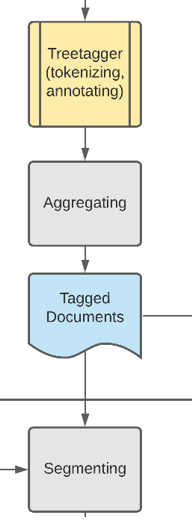

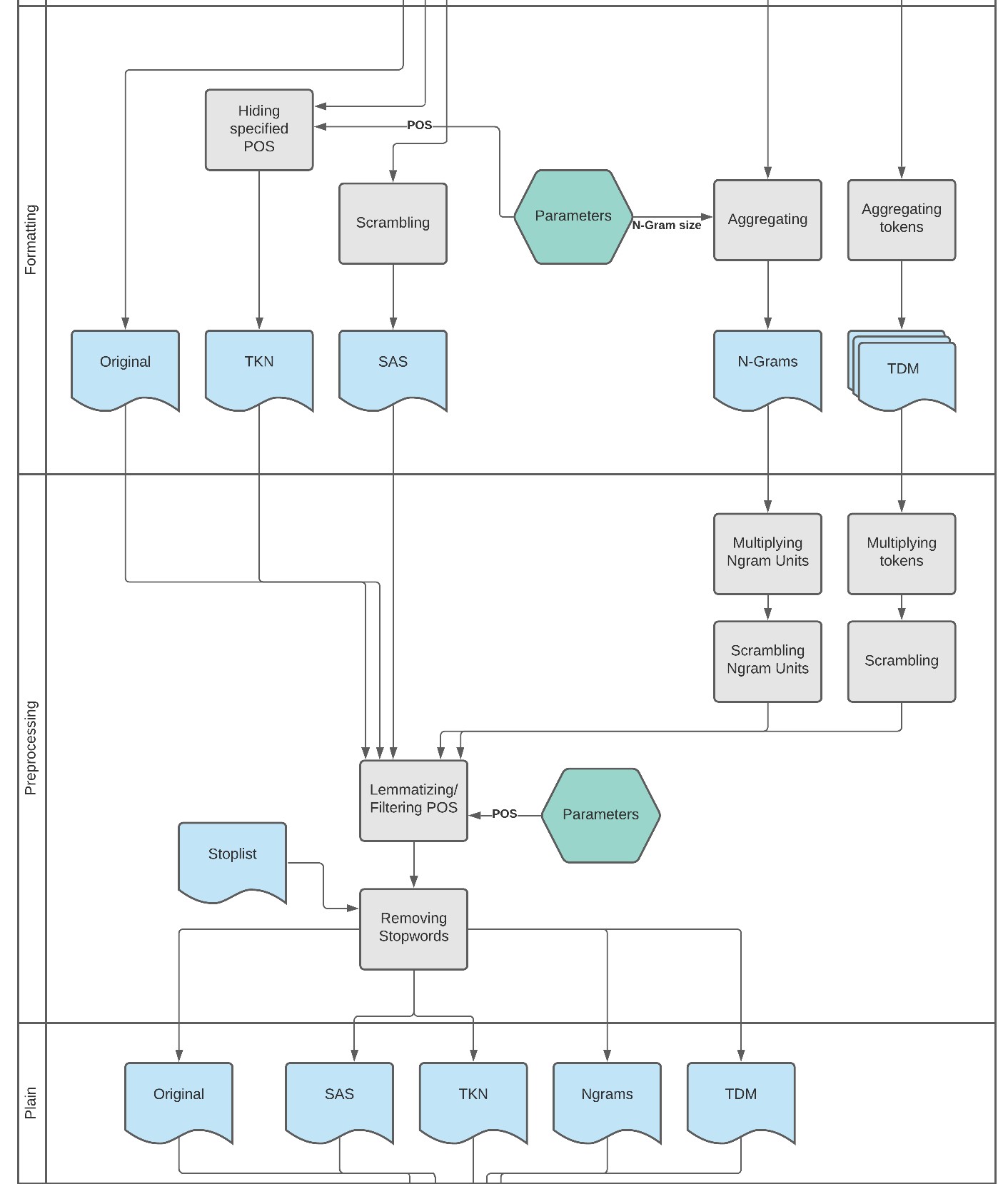

Einen graphischen Gesamtüberblick über den Workflow liefert das im Anhang das im Anhang befindliche Flowchart17 . Diese Grafik ist unterteilt in acht Swimlanes, die jeweils eine Sinneinheit bilden. Die in hellblau hinterlegten Kästen mit wellenförmigen Abschnitt stehen für eine oder mehrere Textdateien. Die gelb hinterlegten Kästen stellen in sich abgeschlossene, externe Programme dar (Tagging und TM) und graue Kästen sind Prozesse, die Bestandteile aus Python-Skripten darstellen und damit selbst geschrieben und implementiert wurden. Die grünen Hexagone stehen für Parameter, die entweder in einer separaten Datei oder im Skript selbst bestimmt werden.

In den folgenden Unterkapiteln werden Ausschnitte daraus präsentiert und im Detail erläutert.

4.1 Das Korpus

4.1.1 Quellen

Noch vor dem Beginn der eigentlichen Pipeline muss das Korpus beschafft werden (Abbildung 5 ). Die Beschaffung der Quelldaten gilt nur für TEI-Dateien, da sich dieser Vorgang nicht verallgemeinern lässt. Sobald allerdings die Daten einheitlich als Textdateien vorliegen, kann der Prozess auf alle Quellen angewandt werden. Im Folgenden werden die für die Erstellung dieses Korpus ausgeführten Schritte erläutert.

Für die hiesige Auswahl des Korpus sind die Kriterien Gemeinfreiheit, Umfang und Homogenität im Fokus. Die Texte sollen gemeinfrei sein, damit sie ohne rechtliche Komplikationen mit dieser Masterarbeit publiziert werden können. Damit können die interessierten Lesenden das Originalkorpus in seiner Gänze betrachten, die abgeleiteten Textformate mit den Skripten aus dem referenzierten Repository erstellen, die hierfür benötigten Schritte selbst nachvollziehen und sie für eigene Forschungszwecke weiterverwenden.

Der Umfang des Korpus ist wichtig, denn ist die Dokumentenanzahl zu klein, mit denen ein Topic Modeling Algorithmus trainiert wird, sind die so erzeugten Topics nur schwierig oder nicht zu interpretieren. Dies kann aus eigener Erfahrung bestätigt werden, denn zu Beginn der Untersuchung wurde das Korpus mit 29 Romanen zu klein gewählt. Die Konsequenz war, dass die Kohärenz der Topics unbefriedigend klein ausfiel, sodass es beim Großteil subjektiv nicht nachvollziehbar war, welche Topics durch die Wörter abgebildet wurden. Zwar ist der Anspruch dieser Masterarbeit nicht die Generierung möglichst kohärenter Topics, doch trotzdem sollte für eine klarere Analyse ein qualitatives Mindestmaß vorhanden sein. Durch Vergrößerung der Textmenge auf 129, stieg die Qualität der Topics dann jedoch deutlich.

Sprachliche Homogenität ist für das Training des TM-Tools wichtig. Homogen sind die Dokumente hinsichtlich ihrer Gattung (Romane), die Hauptsprache ist Englisch18 und ihre Publikationsdaten erstrecken sich über einen Zeitraum von maximal 110 Jahren. Es kann davon ausgegangen werden, dass sich die englische Sprache in diesem Zeitraum nicht zu stark verändert hat, sodass sie vergleichbar bleiben.

Das Korpus besteht aus 129 englischen Romanen aus dem Zeitraum 1810 bis 1920. Es speist sich zum Großteil aus dem englischsprachigen Teil der European Literary Text Collection (ELTeC) (100 Romane) und zu einem Teil aus dem Oxford Text Archive (OTA) (17 Romane).

Weitere 12 Romane sind aus dem im Rahmen der vDHd2021 stattgefundenen Digital-Humanities-Workshop Kontrastive Analyse literarischer Texte mit Zeta (Projekt Zeta Team, 2021; vDHd2021 - Experiments Team, 2021). Dabei handelt es sich um alle im Korpus enthaltenen Romane des Autors Arthur Conan Doyle. Da sie bereits als reine Textdateien vorliegen, müssen diese auch nicht weiter vorverarbeitet werden.

Die ELTeC ist ein Github-Repository19 , das von der European Cooperation in Science and Technology (COST Association) für das Projekt Distant Reading for European Literary History erstellt wurde (Distant Reading for European Literary History, 03/05/2021). Es beinhaltet Texte vieler europäischer Sprachen, die zwischen den Jahren 1840 und 1920 publiziert wurden. Das hat pragmatische Gründe:

(...) we begin in 1840, because starting at around this time, a number of novels that is sufficient for our purposes has been published in many European languages. And we end in 1920 because this allows us to focus exclusively on texts that are in the public domain. As a consequence, ELTeC can be shared freely and re-used as widely as possible, without restrictions imposed by copyright law.

Das Repository wurde also genau für Untersuchungen wie diese geschaffen.20 Durch die Publikation über Github sollten diese Dateien auch langfristig verfügbar sein. Die Dateien liegen in TEI21 kodiert vor und sind durch das Klonen des Repositorys mittels Git oder einem alternativen Git-Client sehr komfortabel und schnell herunterzuladen.

Das OTA ist ein Online-Archiv der University of Oxford (University of Oxford, 2019). Über ihre Suchmaske und Filter lassen sich beispielsweise Sprache und Zeitraum literarischer Werke suchen. Sie liegen uneinheitlich als reine Textdateien, im TEI-Format oder als Kombination aus TEI-Header und Textdatei vor. Die Suchmaske erlaubt es nicht nach gemeinfreien Texten zu filtern, stattdessen sind die Ergebnisse als Publicly Available oder Academic Use gekennzeichnet. Auf diese Weise ließen sich 17 Texte ausfindig machen, die nicht zu weit in der Vergangenheit zurückliegen, dass sie sich sprachlich zu stark vom ELTeC-Korpus unterscheiden und nicht bereits in ihm vorhanden sind. Diese wurden manuell über einen Browser gesucht und heruntergeladen.

Für größere Datenmengen böte sich die Entwicklung eines Spiders für die automatische Erfassung an. Leider gibt es beim OTA oft Weiterleitungen auf ältere Webseiten mit uneinheitlichen HTML-Strukturen und uneindeutige Benennung der Dateien. Der Entwicklungsaufwand, ist im Hinblick auf den Nutzen für wenige Dateien im Vergleich zum manuellen Download, zu hoch. Alternativ könnten Suchmaschinenergebnisse mit Eingrenzung auf die OTA-Website die Navigation erleichtern.

Im Repository befindet sich eine Tabelle, die die Romane im Einzelnen mit Autorschaft, sowie Publikationsdatum und Herkunft aufgelistet.

4.1.2 Vorverarbeitung

Wie beschrieben, liegen viele der ursprünglichen Quelldateien als TEI-XML vor. Sie beinhalten den Text und Metadaten in Form von XML-Tags. Daher ist es notwendig den Reintext aus der XML zu extrahieren und ausgewählte Metadaten in Form einer Tabelle zu sichern. Hierzu wurden Hilfsskripte auf einer Codebasis des Informatikers Maximilan Konzack (Konzack, 2019) geschrieben, welches eine TEI-File parst und die Inhalte in einem TEI-Objekt abbildet. Dieses Objekt beinhaltet aus dem TEI-Header die Namensangaben über Autorinnen, den Titel, das Publikationsdatum (siehe Code 4 ) und den Textinhalt. In Python lässt sich ein XML-Baum als ElementTree aus der nativen Bibliothek xml abbilden und dank XPath-Unterstützung durchsuchen. Eine beispielhafte Erklärung am Datumsfeld:

@property

def date(self):

if not self._date:

xpath = ".//xmlns:bibl[@type=’firstEdition’]//xmlns:date"

self._date = self.root.find(xpath, self.ns).text

return str(self._date)Es ist zu beachten, dass sich jedes Element im Namespace http://www.tei-c.org

/ns/1.0

befindet (siehe Code 5

) und somit auch jeder Knoten im XPath mit dem Präfix

xmlns: versehen ist22, ansonsten werden die

Elemente im Baum nicht gefunden.

<TEI xmlns="http://www.tei-c.org/ns/1.0" xml:lang="en">Die Methode find() nimmt als zweites Argument den o.g. Namespace und liefert den ersten Treffer aus der XML zurück (Code 4 , Z. 5). Die Analyse zeigt, dass nur das date-Element im Abschnitt bibl mit Attribut firstEdition interessant ist, was hier im XPath beschrieben wird (Code 4 , Z. 4). Analog dazu werden die restlichen Metadatenfelder befüllt. Um sie in eine Tabelle zu schreiben wird ein pandas Dataframe23 erstellt, die Spaltennamen festgelegt und die Metadaten übergeben:

result_csv = pd.DataFrame(csv_entries, columns=["Filename", "Lastname", "Firstnames", "Title", "Date"])

result_csv.to_csv(r"tei\metadata.csv", index=False, encoding="utf-8")Die Extraktion des Autorinnennamens gestaltet sich etwas komplexer, weil die author-Elemente einen String nach dem Muster Nachname, Vorname 1 Vornamen (Geburtsjahr-Sterbejahr) beinhalten und keine eigenen Felder für die Einzelteile zur Verfügung stehen. Diese können aber mit Regex-Ausdrücken herausgefiltert werden (siehe Author.py und TEIFile.py).

@property

def text(self):

if not self._text:

divs_text = []

liminal_xp = ".//xmlns:text//xmlns:div[@type=’liminal’]"

body_xp = ".//xmlns:text//xmlns:body"

liminalnode = self.root.find(liminal_xp, self.ns)

bodynode = self.root.find(body_xp, self.ns)

if liminalnode:

for text in liminalnode.itertext():

divs_text.append(text)

for text in bodynode.itertext():

divs_text.append(text)

plain_text = " ".join(divs_text)

self._text = plain_text

return self._textDie Analyse der Quelldaten zeigt, dass sich relevanter Text in den div-Tags mit Attribut type=“liminal“ im Abschnitt front und in den div-Kindern des body-Elements befindet. Die mit liminal typisierten Elemente24 enthalten Prologe und das body-Element den Haupttext eines Romans. Um nun die Textknoten zu extrahieren, nutzen wir die von Python zur Verfügung gestellte Bibliothek xml, die native Unterstützung für XML-Verarbeitung liefert. Sie beinhaltet unter anderem die Funktion Element.itertext(), die über die Kindknoten eines Elements iteriert und die reinen Textknoten zurückliefert. In Code 7 ist demonstriert, wie Prologknoten anhand ihres Types mit XPath gefiltert (Z. 5) und als Liste in einer Variable gespeichert werden (Z. 7). Analog dazu wird mit den body-Knoten verfahren (Z. 6 und 8). Falls es Prologtext gibt, wird er zuerst in einer Gesamttextliste gespeichert (Z. 9-11) und anschließend die Textknoten des body angehängt (Z. 12f). Die Listenelemente werden dann zu einem String zusammengefügt (Z. 14) und in Form einer Textdatei persistiert (siehe import_tei_corpus.py).

Zuletzt werden die Dateien stichprobenartig angesehen, auf grobe Fehler überprüft und ausgebessert. Das gilt insbesondere für die uneinheitlichen Textdateien aus dem OTA. Bei einigen Dateien wurden Regex-Ausdrücke formuliert, um diese auszubessern. Beispielsweise war eine Datei wie eine Tabelle mit zwei tabulatorseparierten Zahlenspalten aufgebaut , die so ausgebessert werden konnte.

4.2 Tagging

Es gibt zahlreiche Online-Tutorials zur Erstellung eines Skripts für die Vorverarbeitung von Texten. Viele empfehlen die Nutzung der populären Bibliothek spaCy (spaCy Dev Team, n. d. a). Sie ist in Python geschrieben und stellt ein mächtiges Werkzeug zur Sprachdatenverarbeitung dar. spaCy liefert u.a. eine anpassbare Pipeline für Tokenizing, Tagging und Parsing, die auf vortrainierten Korpora agieren (spaCy Dev Team, n. d. b). Ursprünglich hat der Autor ein Skript zur Vorverarbeitung der Originaltexte auf Basis dieser Pipeline erstellt, doch die Formatting-Skripte von Schöch sind auf Basis des Treetaggers geschrieben. Um eine vergleichbare Basis durch einheitliche Segmentgrößen und Tagging zu gewährleisten, wurde dieser Ansatz zugunsten des Treetagger jedoch verworfen, um Aufwände zu verringern. spaCy sei aber nachdrücklich als gute, moderne Alternative empfohlen.

Der Treetagger ist ein von Helmut Schmid im Rahmen des an der Universität Stuttgart initiierten Projekts Textual corpora and tools for their exploration (University of Stuttgart, 2021) entwickeltes Tool zur Textannotation mit POS- und Lemmainformationen. Es wird von allen gängigen Betriebssystemen unterstützt und ist in vielen Sprachen anwendbar (Schmid, 1994; Schmid, 1995). Um es als eigenes Kommandozeilentool zu nutzen, ist der Download von der offiziellen Webseite erforderlich und den spezifischen Installationsanweisungen zu folgen: https://cis.uni-muenchen.de/~schmid/tools/TreeTagger/. Als Python-Paket steht es dann zur Verfügung, wenn der treetaggerwrapper über PiPy mit pip install treetaggerwrapper installiert wird.

|

|

|

|

| Token | POS | Lemma |

|

|

|

|

| There | EX | there |

| ’s | VHZ | have |

| been | VBN | be |

| a | DT | a |

| woman | NN | woman |

| here | RB | here |

| , | , | , |

| ” | ” | ” |

| he | PP | he |

| cried | VVD | cry |

| . | SENT | . |

|

|

|

|

Tabelle 3 repräsentiert beispielhaft eine Ausgabedatei, die mit dem Treetagger erstellt wurde. In der ersten Spalte werden Token aufgelistet, also die Wörter und Zeichen, wie sie tatsächlich im Text vorzufinden sind. Die zweite Spalte enthält die POS-Tags aus dem PENN-Tagset25 . In der dritten Spalte, Lemma, werden die auf ihre Grundform zurückgeführten Wörter aufgelistet, die die Basis für Topic Modeling darstellen. Diese Einheit wird im weiteren Verlauf auch als Feature bezeichnet. Interpunktionen werden auch als solche erkannt und Satzgrenzen gesondert mit SENT versehen. Interessant ist dabei, dass im Englischen mit Apostroph abgekürzte Wörter ebenfalls auf ihre Grundform zurückgeführt werden und hier ’s korrekt als have und nicht etwa als be erkannt wurde.

Das Spaltenabgrenzungszeichen ist standardmäßig der Tabulator. Behält man jenes so bei, ist es logisch, für jeden getaggten Text auch je eine Tag-Datei zu erstellen. Bei großen Korpora führt das dazu, dass eine Vielzahl von Dateien im Filesystem liegen, die der Übersichtlichkeit schaden. Deswegen wurde stattdessen der Unterstrich als Trennzeichen verwendet, damit alle Dokumente zeilenweise gespeichert werden können. Auch die anderen Formate sollen, so weit möglich und sinnvoll, auf diese Art gespeichert werden. Dieser Prozess wird im Chart als Aggregating bezeichnet. Als Ergebnis erhält man dann Texte in dieser Form:

ENG18450_Disraeli\tSybil_NP_Sybil ,_,_, or_CC_or the_DT_the Two_CD_two

Nations_NPS_Nations\n

ENG18410_Sinclair\tThe_DT_the newspapers_NNS_newspaper have_VHP_have

recently_RB_recently adopted_VVN_adopt\nDurch Auftrennung am Zeilenumbruch erhält man einen Roman, an einem Tab den Dateinamen und Inhalt und an einem Leerzeichen die Liste aller Features.

def apply_tagger(text, params):

tagger = treetaggerwrapper.TreeTagger(TAGLANG=params["lang"])

tagged = tagger.tag_text(text)

tagged = [tag.replace("\t", "_") for tag in tagged]

tagged = " ".join(tagged)

return taggedDie Erstellung dieser Datei ist denkbar einfach, s. Code 9 . Der aus treetagger importierten Klasse Treetagger wird beim Instanzieren im Konstruktor ein Sprachkürzel übergeben (Standard ist en), um festzulegen, in welcher Sprache die Quelltexte geschrieben wurden (s. Kap. 4.4 ). Dieses Objekt ruft die Methode tag_text mit dem Quelltext als Argument auf und liefert eine Liste mit Zeilen zurück, die aufgebaut sind wie in Tabelle 3 , dessen Tabs in Strings mit Unterstrichen ersetzt werden. Die Elemente werden dann in einem String zusammengeführt und als Datei gespeichert.

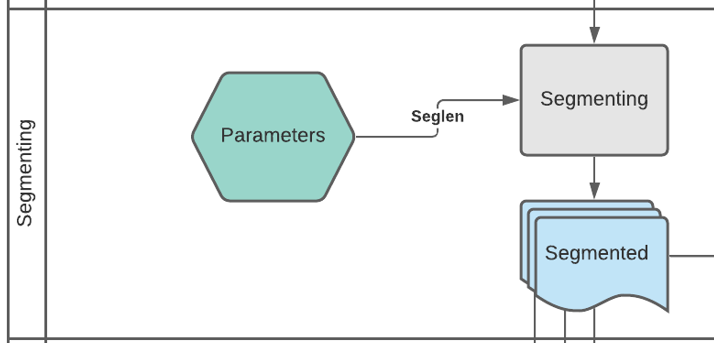

4.3 Segmenting

Der wohl wichtigste Parameter bei der Erstellung der Formate, stellt die Segmentierung dar. Mit ihm wird bestimmt wie groß ein Dokument jeweils ist und beeinflusst damit indirekt die Anzahl der Dokumente, denn je größer die Segmentgröße, desto kleiner die Dokumentanzahl und umgekehrt. Das Ziel ist die Erstellung mehrerer segmentierter Dokumente, die als Grundlage der meisten Formate dient.

Hierfür wurde das Skript formats0_segmenting.py geschrieben, das die Tagged-Datei einliest, daraus Segmente generiert und diese in eigenen Dateien abspeichert. Der Name einer Segmentdatei setzt sich zusammen aus dem Präfix segmented- und der Segmentlänge, die aus der Parameterdatei (s. Kapitel 4.4.2 ) ausgelesen wird, also z.B. segmented-500.txt für Segmentlänge 500.

def create_segments(tagged, params):

tagged = tagged.split(" ")

segments = [tagged[x:x+params["seglen"]] for x in range(0,len(tagged), params["seglen"])]

return segmentsDie Funktion create_segments() in Code 10 stellt das Herzstück dar. Sie erhält das zu segmentierende Dokument in Form eines Strings, dessen Inhalt an einem Leerzeichen aufgespalten wird (Z. 6). Damit wird eine Liste erzeugt, die alle Features des Dokuments enthält. Die eigentlichen Segmente werden in Z. 7 generiert: es wird in einer List-Comprehension26 über die Elemente der eben erzeugten tagged-Liste iteriert. Der Ausdruck for x in range(0, len(tagged), params[’seglen’]) bedeutet, dass x in jeder Iteration um die Segmentgröße (z.B. 500) erhöht wird. Mit tagged[x:x+params[’seglen’] wird bestimmt, welche Features von tagged in einer Unterliste zusammengefasst werden sollen. Setzt man x der ersten Iteration ein, ergibt sich der Ausdruck tagged[0:0+500]. D.h. die Elemente 0-499 sind nun in einem Dokument zusammengefasst (die zweite Zahl, hier 500, ist exklusiv). In der nächsten Iteration ist x um die Segmentgröße erhöht, also ist x == 500, was bedeutet, dass sich die nächsten Listenelemente aus tagged[500:500+500] ergeben. Dies wird so lange fortgeführt, bis die Liste keine Elemente mehr hat. In den meisten Fällen wird das bedeuten, dass das letzte Dokument aus weniger Elementen besteht, sofern die Gesamtanzahl an Features kein Vielfaches der Segmentgröße ist.

Die Funktion write_to_file() nimmt die so erzeugten Dokumentlisten und schreibt sie zeilenweise, als String zusammengefügt, in die Ausgabedatei. Jede Zeile erhält noch tabulatorsepariert den Quelldateinamen zur Identifikation und Kontrolle.

4.4 Formatting

Zur Erstellung der Textformate dienen als Grundlage Skripte, die Schöch im DH-Trier-Repository zum Download zur Verfügung stellt (https://github.com/dh-trier/tmr). Diese wurden so modifiziert, dass sie als Teil dieser Pipeline funktionieren können.

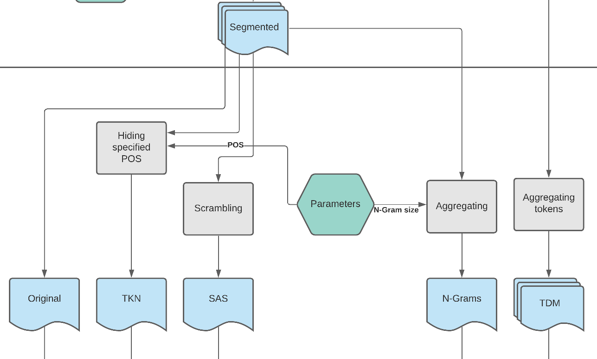

Abbildung 8 stellt die Swimlane Formatting vor. Damit kann sich eine Übersicht über die Prozessschritte verschafft werden und sie zeigt, wie sich die Formate voneinander unterscheiden.

Auf der linken Seite befinden sich neben dem Original die textähnlichen Formate Segmentweise Aufhebung der Sequenzinformationen (SAS) und Selektiv reduzierte Information über einzelne Tokens (TKN). Rechtsseitig sind die tabellarischen Formate N-Gramme (N-Grams) und Term-Dokument-Matrix zu sehen. Mittig sind die Parameter im grünen Hexagon symbolisiert. Von ihm gehen mehrere beschriftete Pfeile zu diversen Prozessschritten aus. Es ist zu sehen, dass alle Formate bis auf die Term-Dokument-Matrix (TDM) aus den zuvor erstellten Segmenten generiert werden. Das liegt daran, dass sie nicht auf Subdokumentebene erstellt werden soll, sondern auf Basis ganzer Texte.27

4.4.1 Die Ordner- und Kontrollstrukturen

Für die Pipeline wurde eine stufige Ordnerstruktur erstellt:

- 0_source. Dieser Ordner enthält den nicht-annotierten Korpus in Form von Textdateien für jeden einzelnen Roman.

- 1_tagged. Das Skript formats0_tagging.py erstellt für jedes Token des Originals eine Zeile mit POS-Angaben und ihrer Grundform.

- 2_segmented enthält Textdateien, die das Resultat des segmentierten getaggten Textes darstellen.

- 3_formats beinhaltet die von den formatting-Skripten erstellten Textformate.

- 4_plain ist der Ort für die aus den Textformaten erstellten Pseudotexte.

- 5_corpus. Darin befinden sich die für das TM vorverarbeiteten Texte. Aus diesen werden schließlich die Topics abgeleitet.

- 6_evaluation enthält diverse Daten für die Evaluation: Modelle, Kohärenzen und Plots.

Ab dem Ordner 3_formats sind Unterordner pro erstelltem Textformat und Segmentlänge enthalten. Die Unterordnernamen bestehen aus zwei Teilen, z.B. seglen-500. Dabei dient seglen als Identifizierung, dass es sich um die Segmentlänge handelt und 500 ist die Segmentgröße, mit die darin befindlichen Textdateien erstellt wurden. Die Ausnahme bildet die TDM, weil die ihr zugehörigen Dateien zuerst in einem eigenen Ordner namens tdm abgelegt werden. Das liegt daran, dass die TDM nicht aus einer Segmentdatei erstellt wird, sondern aus der Tagged-Datei. In den darauffolgenden Ordnerstufen wird aber auch dieses Format in den jeweiligen Segmentordnern abgelegt, weil es bei der Transformation zur Textform ebenfalls in die jeweiligen Segmente unterteilt wird.

Angelehnt an Schöchs Skript run_formats.py, dient run_preprocess.py als Steuerung für die Verarbeitungsskripte. Unter Call imported scripts werden sie eingebunden und können durch Auskommentierung, z.B. mittels einer Raute (#) am Zeilenanfang, aktiviert bzw. deaktiviert werden. Als Argumente erhalten sie die ihnen zugehörigen Ordner (s.o.), deren Pfade relativ zum aktuellen Projektverzeichnis im Abschnitt Files and folders gesetzt werden. Es kann durch Parametrisierung gesteuert werden, welche Formate eingelesen werden.

def check_inputfile(path, taggedfile):

if not path.is_file():

print"Segmentfile not found. Creating segmentfile ", params[’seglen’])

formats0_segmenting.main(taggedfile, input_segmentsfolder, params)

return pathUm zu garantieren, dass für jede gewählte Segmentgröße die passende Quelldatei zur Verfügung steht, wurde die Hilfsfunktion check_inputfile() (Code 11 in run_formats.py eingefügt. Sie prüft, ob die Segmentdatei existiert (Z. 2) und ruft das Segmentierungsskript auf, falls dem nicht so ist. Auf diese Weise wird beim Aufruf des Skriptes immer ein Format mit der richtigen Segmentgröße erzeugt und, was es für Nutzende benutzerfreundlicher macht.

4.4.2 Parameter

Die Parameter werden in der Datei parameters.py definiert. Dort befinden sich mehrere vordefinierte Variablen die von Benutzenden befüllt werden müssen, welche dann im Dictionary params zusammengefasst und an die run-Skripte weitergegeben werden.

In der Variable seglen wird die Segmentlänge als Integer bestimmt. Sie ist relevant für alle Prozessschritte die das Label Segmenting im Flowchart tragen und für die Dateibenamung. Jede segmentierte Datei erhält zur eindeutigen Identifikation die Segmentlänge als Teil des Namens.

Der Parameter casing bestimmt, ob Wörter ihre Groß- und Kleinschreibung behalten (’original’) oder ausschließlich kleingeschrieben sein sollen (’lower’). Gerade für englische Texte erscheint diese Option nicht besonders relevant, könnte für das Deutsche interessant sein.

Mit token wird bestimmt welcher Teil der Features verwendet werden. Dieser Parameter ist interessant für das Format mit selektiver Aufhebung der Tokens und N-Gramme.

Parameter pos ist ein inkludierender Filter, der bestimmt, welche Wortarten im Text bleiben sollen. Alle nicht hier definierten Tags werden entfernt.

Mit ngram wird die Länge der N-Gramme im Textformat N-Gramme bestimmt.

Das Dictionary wird von den Kontrollskripten run_formats und run_preprocess importiert und jeweils an die dort aufgerufenen Skripte weitergegeben. So teilen sich alle Verarbeitungsskripte die gleichen Parameter, was die Erstellung und Weiterverarbeitung der Formate erleichtern soll.

Alle Formatting-Skripte lesen Dokumente zeilenweise aus der jeweiligen Segmentdatei (oder aus der Tagged-Datei) aus, die auf ihre spezifische Weise verarbeitet und anschließend an unterschiedlichen Orten gespeichert werden.

4.4.3 Selektiv reduzierte Information über einzelne Tokens

Dieses Format wird mit dem Skript formats1_tkn generiert. Relevant sind die Parameter token und pos. Die erlaubten Werte für token sind ’lemma’, ’pos’ und ’mixed’. Wurde der erste Wert bestimmt, werden alle Lemmata zurückgegeben, beim zweiten nur die Wortform und beim letzten wird gefiltert. Dafür wird ausgelesen, welche Wortformen in pos erlaubt wurden und nur diese werden als gesamtes Feature in das Format übernommen. Alle restlichen Token werden stattdessen als POS-Tag in den String geschrieben. Dafür bietet sich ein Switch in Form von aufeinanderfolgenden If-Else-Statements an, die testen, welcher Parameter für die Wortartfilterung ausgewählt wurde. Für TM erscheint nur die gemischte Version sinnvoll, da somit sichergestellt ist, dass die semantisch wertvollen Wortformen erhalten bleiben, aber der Text als solcher nicht mehr rekonstruierbar wird.

Die Auswahl des richtigen Teilfeatures geschieht durch Splitting des Feature-Strings am Unterstrich:

if len(token.split("_")) == 3:

if token.split("_")[1] in params["pos"]:

features.append(token)

else:

features.append(token.split("_")[1])In Code 12

ist zu sehen, wie gefiltert wird. Als Eingabe wird beispielhaft

’window_NN_window’ definiert. Wird dieser zerlegt entsteht die Liste [’window’, ’NN’,

’window’]. In Z. 1 wird zunächst geprüft, ob sich der eingegebene String

token auch in

drei Teile zerlegen lässt. Damit wird vermieden, dass fehlerhafte Features aus der

Tagged-Datei übernommen werden. Es zeigte sich, dass an Stellen, an denen der

Text nicht richtig gesäubert werden konnte, der Treetagger vom üblichen

Tagging abweicht. Dies geschieht beispielsweise, wenn der Tagger fälschlich ein

Domain Name System (DNS) erkennt, weil Wörter nicht richtig von einem Punkt

abgetrennt sind, z.B. wenn am Satzende ’refresh.Anne’ geschrieben steht.

Wenn der Tagger dies als Domain erkennt, wird stattdessen das Feature mit

’replaced-dns_NNS_replaced-dns’ ersetzt. Dahinter wird ein XML-Tag mit dem

ersetzten Tag als Attribut gesetzt <repdns text=’refresh.Anne’/>. Diese

Information

ist nicht zu gebrauchen und der Tag wird durch die Prüfung in Z. 1 ignoriert. Das hat

aber auch zur Folge, dass ’replaced-dns_NNS_replaced-dns’ nicht herausgefiltert

wird28 .

Der String wird daher als Stoppwort aufgenommen und verbleibt für das TM nicht mehr

im Text. Dass überhaupt solche Fehler auftauchen, liegt vermutlich am Tagging der

XML-Datei. Eine Vielzahl dieser Fehler konnte mit einfachen Regex-Ausdrücken

korrigiert werden. Daher sei an dieser Stelle nochmal auf die Bedeutung des

Prozesses Revision in Abbildung 6

für die Erstellung möglichst guter TM

verwiesen.

In Z. 2 wird geprüft, ob der zweite Teil des Splits Teil der Wortformmenge ist. Es wird angenommen, dass dem so ist, also wird der ganze Feature-String der Ausgabeliste hinzugefügt. Im anderen Fall, würde nur die Wortform (NN) aufgenommen werden. Diese Liste wird als String mit ’ ’.join(features) zusammengesetzt und erhält damit das fertige Format, das abgespeichert werden kann.

Der Name der fertigen Datei beginnt mit dem Formatsprefix gefolgt von einem Bindestrich. Dahinter folgen die definierten Wortartkürzel in alphabetischer Reihenfolge, welche mit je einem Unterstrich getrennt sind. Der fertige Dateiname kann beispielsweise diese Form annehmen: tkn-NN_NNS.txt. Es handelt sich also um das Format, bei dem nur noch die Substantive erkenntlich sind. Nachteil bei diesem Vorgehen ist, dass der Dateiname recht lang ausfallen kann, aber dadurch gestaltet sich im späteren Verlauf der Pipeline die Filterung nach dem POS-Set sehr einfach.

4.4.4 Segmentweise Aufhebung der Sequenzinformation

Das Format wird vom Skript formats2_src.py generiert und abgespeichert.

Ursprünglich beinhaltete Schöchs Skript den Segmentierungsprozess in dieser Datei, doch wurde dieser wie oben beschrieben in einen eigenen Schritt ausgelagert. Zentral ist daher der Randomisierungsschritt der Token innerhalb eines Segmentes, was mit der Methode shuffle() aus der nativen Python-Bibliothek random realisiert werden kann:

import random

random.shuffle(seg) # scrambling

seg = " ".join(seg)shuffle() erhält als Argument die zu randomisierende Segmentliste seg und speichert das Ergebnis in einem wieder zusammengesetzten String.

Hiermit ist das Format schon erstellt und es benötigt hiernach keine weitere Vorverarbeitung mehr, um als Pseudotext im Ordner 4_plain gespeichert zu werden.

4.4.5 Term-Dokument-Matrix

Zur Generierung dieses Formates wird das Skript formats_frq ausgeführt. Als Parameter erhält es mit casing lediglich die Information, ob Groß- und Kleinschreibung beachtet werden soll. Wird der Wert ’lower’ eingetragen, werden alle Wörter kleingeschrieben, bei ’original’ hingegen, bleibt das Casing unverändert. Für TM ist das Casing irrelevant, daher wird dieses Format standardmäßig im Modus ’lower’ ausgeführt. Es könnte im Englischen für Lesende als visueller Hinweis auf Namen dienen und bei deutschen Texten die manuelle Suche nach Substantiven erleichtern, ist darüber hinaus aber uninteressant.

Zentraler Vorverarbeitungsschritt ist die Aggregierung der Tokens. Das Skript liest die Tagged-Datei aus und generiert mit der Funktion get_counts(features) das Format:

import pandas as pd

def get_counts(features):

counts = pd.Series(Counter(features))

counts.sort_values(inplace=True, ascending=False)Mit Code 14 wird die externe Bibliothek pandas (McKinney, 2010; The pandas development team, 2020) importiert. Diese kann beispielsweise mit über das Python Package Index mit pip install pandas oder aus einem anderen Python-Repository (z.B. conda-forge) installiert werden. Es handelt sich um eine sehr mächtige Bibliothek zum Erstellen und Bearbeiten von Datensätzen, meist in Form von Tabellen. In Zeile 3 wird aus der Eingabeliste, den Features, ein Series-Objekt erstellt, dass aus einer Menge von Python-Tuples besteht. Diese beinhalten jeweils zwei Elemente: Zum einen das Feature und zum anderen dessen Häufigkeit (z.B. (’the_DT_the’, 2317)). Diese werden dann nach Letzterem sortiert (Z. 4) und in einer Datei tabulatorsepariert gespeichert.

4.4.6 N-Gramme

Das Skript formats_ngr.py erstellt N-Gramme auf Basis eines Segmentes und fügt sie in einer Datei zusammen. Ursprünglich beinhaltete das Skript keine Option, Token-Features als Ganzes beizubehalten. Stattdessen war es nur möglich ihre Einzelteile auszugeben (Lemma, Wortart oder Token). Daher wurde in der Funktion select_features die Unterstützung für den token-Parameter für den Wert mixed hinzugefügt. Das sorgt dafür, dass das gesamte Feature beibehalten wird. Wichtig ist, dass, damit jedes Format auf die gleiche Weise vom Vorverarbeitungsschritt am Ende der Pipeline bearbeitet werden kann.

Die Aggregation findet in der Funktion create_ngrams() statt.

def create_ngrams(ngrams, params):

ngrams = zip(*[ngrams[i:] for i in range(params["ngram"])])

ngrams = [" ".join(ngram) for ngram in ngrams]In Z. 2 von Code 15 wird mit zip() ein Iterator gepackt, welches N-Gramme der Größe params[’ngram’] als Tuple ausgibt. Als Input dient die Liste ngrams, die die gefilterten Lemmata enthält. Dann wird jedes Tuple als ein N-Gramm als String-Element in einer Liste zusammengefügt (Z. 3).

So entstehen alle N-Gramme für dieses Segment. Mit der Funktion count_allngrams werden diese gezählt und zusammengefasst.

def count_allngrams(allngrams, params):

from collections import Counter

allcounts =dict(Counter(allngrams))

filteredcounts = dic()

for (key, value) in allcounts.items():

if value > params["threshold"]:

filteredcounts[key] = valueIn Code 16 wird in Z. 2 Counter importiert. Er nimmt als Argument eine Liste der N-Gramme auf Segmentbasis, addiert gleiche Vorkommen auf und speichert sie als dict() mit dem String als key und die Summe als value ab (Z. 3). Anschließend wird durch jedes Key-Value-Paar iteriert und geprüft, um der die Summe größer ist als der in ’threshold’ definierte Integer. So werden nur N-Gramme übernommen, die das Mindestvorkommen erfüllen (Z. 5-7).

Sie können dann gespeichert werden. Dafür werden die Segmente im CSV-Format in die Datei geschrieben, auf den der Separator-String <seg> folgt. Damit sind alle Segmente in einer zusammengefassten Datei gespeichert und trotzdem voneinander unterscheidbar.

4.5 Preprocessing

Das Preprocessing ist der Schritt, bei dem die Formate in Textstrukturen überführt werden. In diesem Kapitel wird beschrieben, welche Schritte für die jeweiligen, aus den Formaten generierten, Pseudotexte durchgeführt wurden, um einen validen Input für das TM zu generieren.

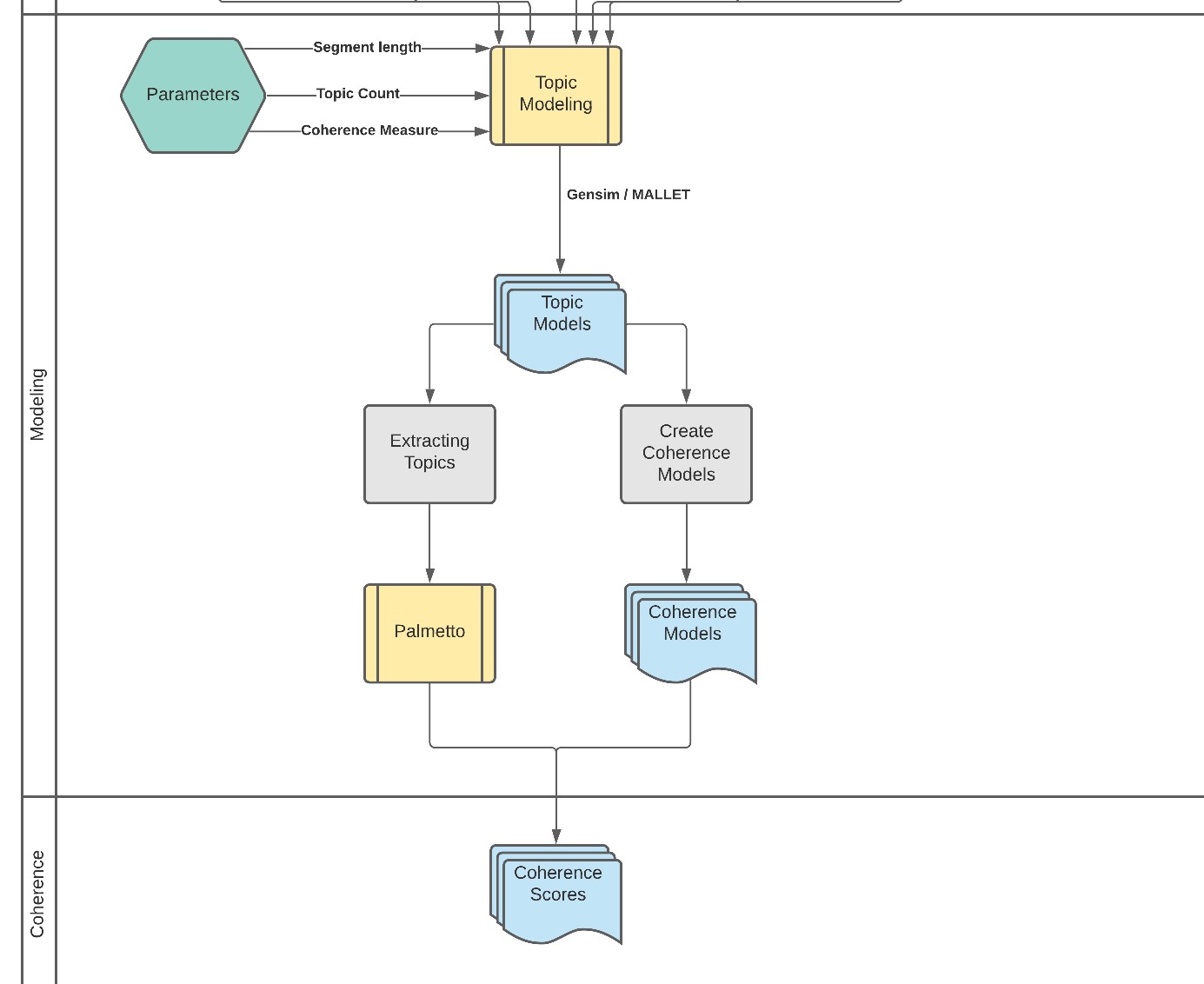

In Abbildung 9 ist schematisch die Übersicht über den gesamten Preprocessing-Prozess gegeben. Die Swimlane Preprocessing schließt sich nahtlos an Formatting an. Die dort dargestellte Pfeile führen von den Formatdateien weg. Es ist zu erkennen, dass die linksseitigen Formate weniger vorverarbeitet werden müssen, als die tabellarischen Formate N-Gramme und TDM auf der rechten Seite.

Für den Preprocess wurden drei Skripte erstellt, die die Eigenheiten der Formate beachten:

- seg2plain.py für den originalen Volltext der Segmente.

- tkn2plain.py für die Selektiv reduzierte Information über Tokens

- frq2plain.py für die Term-Dokument-Matrix

- ngrams2plain.py für die N-Gramme

Für das SAS-Format wird keine spezifische Vorverarbeitung mehr benötigt, es speist sich unmittelbar in die generelle Vorverarbeitung. Die letzten beiden Subprozesse Lemmatizing/Filtering POS und Removing Stopwords werden in preprocess.py durchgeführt. Hierzu ist keine weitere Formatsdifferenzierung notwendig.

4.5.1 Das Original und Selektiv reduzierte Information über einzelne Token

Das Skript seg2plain.py ist trivial, denn alles was nötig ist, um eine Segmentdatei zu bereinigen, ist das Entfernen des Quelldateinamens. Damit ist das Originalformat schon bereit für die allgemeinen Vorverarbeitungsschritte.

Das Skript tkn2plain.py funktioniert auf die gleiche Weise. Es unterscheidet sich dadurch, dass es beim Aufruf in run_preprocess.py den Formatsordner 3_formats statt einer Segmentdatei erhält und ein Filter eingebaut ist, der im Namen der dort enthaltenen Dateien das Präfix tkn sucht.

4.5.2 Term-Dokument-Matrix

Die TDM stellt eine größere Herausforderung da, weil sie keine Textstruktur besitzt. Als Input dienen mehrere Textdateien, die je eine Matrix beinhalten. Zwischen jeder Inhaltszeile befindet sich eine leere Zeile, die durch die Funktion to_csv() im Skript formats2_frq erstellt wurden. Sie erstellt aus einem pandas-Series-Objekt Zeilen mit einem Separator, in diesem Fall Tabulator. Nach jeder Zeile wird jedoch eine Leerzeile eingefügt, die beim Einlesen wieder entfernt werden sollte.

file.read().split("\n\n")Der Code 17 erhält die TDM-Datei als Argument, liest den Inhalt aus und gibt eine Liste mit dem jeweiligen Zeileninhalt zurück. Dieser kann beispielsweise so aussehen: ’a_DT_a\t961’.

Mit dieser Information kann also der Feature-String durch Multiplikation vervielfältigt werden.

def create_text(lines):

text = []

for l in lines:

if len(l.split("\t")) == 2:

tkn_info = l.split("\t")[0]

count = int(l.split("\t")[1])

for i in range(count):

text.append(tkn_info)